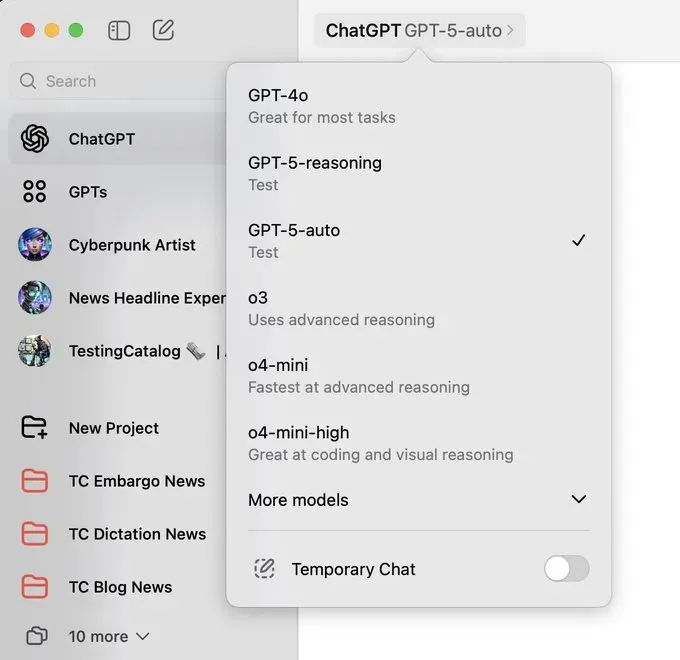

时不时有点料,但又不是真发布,前面有挖出GPT-5-Auto和GPT-5-Reasoning两个神秘模型;接着又传出微软的Copilot和Cursor也已经偷偷用上了GPT-5进行内测。

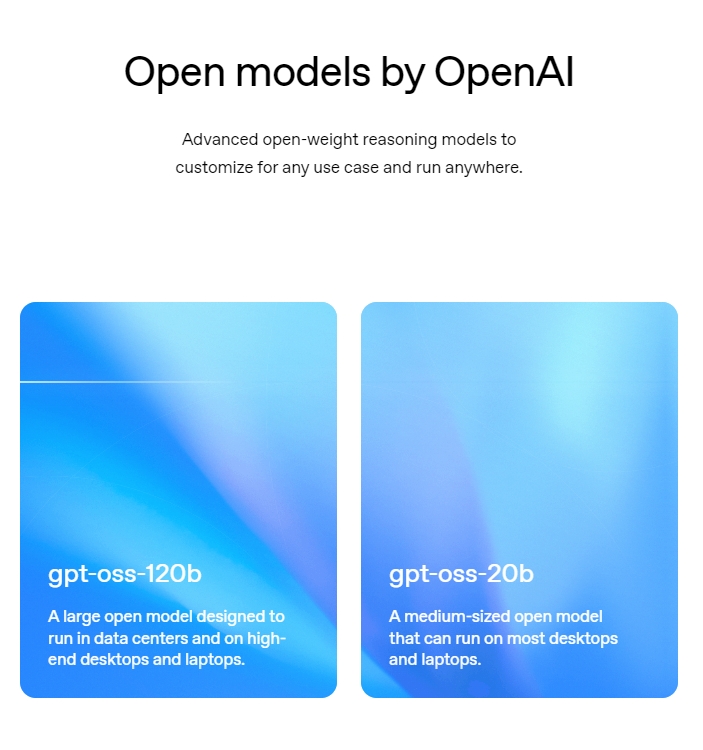

这难道是在搞测试?但今天苏米要说的是GPT-5虽然难产了,但昨天却开源了两大全新顶级模型:gpt-oss-120b 、 gpt-oss-20b,OpenAI毫无预兆地放了个大招,不仅直接官宣发布开源模型,还一口气来了两个!

没错,就是大家疯狂猜测、屡次"泄密"的那波,正是120B和20B两个不同规模,分别命名为gpt-oss-120b和gpt-oss-20b。

Apache 2.0开源

跟以往的"GPT系列"不一样,这次是完全开放参数模型(open-weight),参数文件直接下载,代码、架构、推理方法全部敞开。通俗点说,你可以像搬家一样把OpenAI的"智慧"搬到自己电脑、服务器,甚至笔记本上,想怎么玩怎么玩,不需要API,零门槛自助可控。

-

• gpt-oss-120b:1170亿参数,采用MoE(Mixture-of-Experts)技术,能在一张80GB的H100显卡上单独运行,推理速度堪比O4-mini。适用于超高推理能力、高并发场景。

-

• gpt-oss-20b:210亿参数,普通16GB内存的设备都能带动,甚至消费级笔记本都能本地用!本地化、低延迟、专属小型应用直接无压力。

两个模型都挂着Apache 2.0开源协议,没有任何限制,爱怎么用怎么用,敢想敢造就是你的自由!

优势亮点

这次GPT-OSS不是"纯大力模型",而是混合专家架构(MoE):一个模型里有多组专家,推理时只激活一部分,既保证大模型的记忆力,又能节省显存。举个例子,gpt-oss-120b虽然总参数1170亿,但推理时只有5.1亿参数被激活,用一次只吆喝一个"智囊团"干活,除此这外还有多个亮点:

极致性价比与灵活部署

gpt-oss-20b直接可以笔记本跑,办公、小型私有部署、边缘计算场景直接起飞。gpt-oss-120b则是高性能场合王炸,一块卡吃掉过去一排服务器的活。

透明可控,安全可自查

全部参数开放,没有黑箱,每个推理路径你都能可视化,开发者和研究者的福音。

顶级推理能力+全链路开源

OpenAI宣称,gpt-oss-120b推理能力接近自家O4-mini,gpt-oss-20b媲美O3-mini——这都是业内一线的性能。

多用途,灵活可微调

两个模型都支持自定义微调+链式思维(chain-of-thought)推理,可做多轮任务、代码分析、复杂推理,甚至直接"复用"OpenAI Harmony响应格式,低代码迁移。

工具调用,原生Agent能力

支持函数调用、网页浏览、Python代码执行、结构化输出……什么"智能体Agent",这就是"原生地表最强"。

部署成本

Hugging Face、Ollama、Northflank等平台第一时间上线了一键部署方案,不会Docker不会云也能玩转开源AI。

OpenAI和合作伙伴直接集成了主流AI推理引擎(如vLLM、Transformers Serve、Ollama等),一行命令直接拉起本地服务。

简单pip install、huggingface-cli或transformers调用,笔记本开发、云端生产一把梭。

结语

OpenAI自GPT-2后首次完全开源高性能大模型,结束了长达6年的API+闭源垄断。

Meta Llama、Mistral、Deepseek、Qwen等强力开源模型,迎来史诗级对手。这下"生态混战"直接升级,未来一年开源AI领域必然腥风血雨。

开源是加速混战的重要武器,且看OpenAI持续发力!

模型资源链接

-

OpenAI 官方发布页面:https://openai.com/open-models/

-

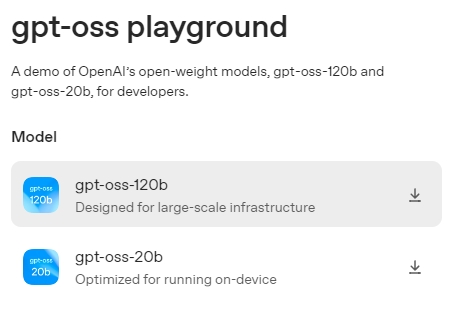

OpenAI 体验地址页面:https://gpt-oss.com/

-

GPT-OSS-120B 模型:https://huggingface.co/openai/gpt-oss-120b

-

GPT-OSS-20B 模型:https://huggingface.co/openai/gpt-oss-20b