最近在浏览开源项目时,发现面壁智能OpenBMB在2月开源的MiniCPM-o 4.5登上了Hugging Face热榜第2。

作为一个长期关注端侧AI部署方案的产品经理,我对这个项目特别感兴趣——它在参数量仅9B的约束下,声称能接近Gemini 2.5 Flash/GPT-4o的多模态能力,这种规格和性能的组合确实值得分析。

一、项目核心定位

MiniCPM-o 4.5本质上是一个端侧友好的开源全模态大模型,其核心差异化体现在三个维度:

1. 全模态能力(Omni-Modal)

- 支持图像、视频、文本、音频的并行输入

- 输出形式包括文本和语音

- 在统一的语义空间中完成跨模态理解,而非各模态独立处理后的拼接

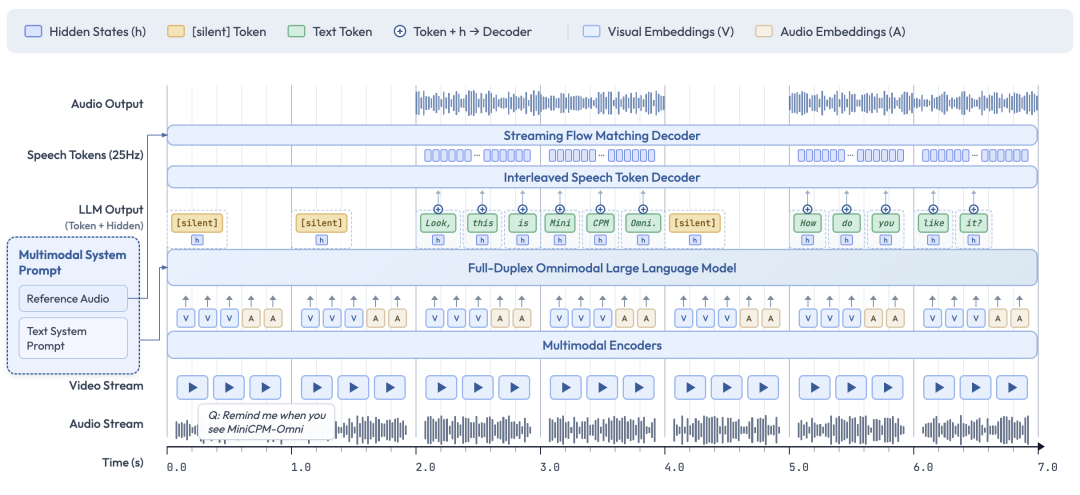

2. 全双工交互(Full Duplex)

这是MiniCPM-o 4.5相比传统对话式AI的核心创新点:

- 传统模式:对讲机式的回合制问答——用户说完,模型处理,模型回复

- 全双工模式:模型持续接收视觉输入和语音输入,同时生成语音输出,三者并行进行,且用户可随时打断或插话

这意味着模型在说话时,视觉理解和语音识别不会暂停,延迟和交互体验都有显著提升。

3. 端侧部署优先(Edge-Native)

- 参数量9B,相比70B+的通用大模型,显存需求大幅降低

- 可在消费级GPU、手机、车机、机器人等边缘设备上原生运行

- 已适配国产芯片生态(天数智芯、华为昇腾、平头哥等)

二、技术架构分析

MiniCPM-o 4.5的"小而全"并非偶然,其技术选型值得关注:

模块化架构设计

- 语言底座:Qwen3-8B

- 视觉编码:SigLIP2(高效视觉特征提取)

- 语音识别:Whisper(开源语音理解)

- 语音生成:CosyVoice2(自然度较高的语音合成)

- 统一架构:端到端的共享语义空间,而非松散的模块拼接

关键技术创新

| 技术维度 | 实现方式 | 效果 |

| 全双工语音解码 | 文本token + 语音token交错建模 | 输出语音时仍可接收新输入;长语音音色统一、语气自然 |

| 视觉处理 | 高效backbone + token压缩策略 | 高分辨率图像和多帧视频用极少token表示;视频性价比高 |

| 跨模态推理 | 统一语义空间,不分模态处理 | 理解"谁在说话""刚发生了什么"等复杂场景 |

三、部署和使用方案

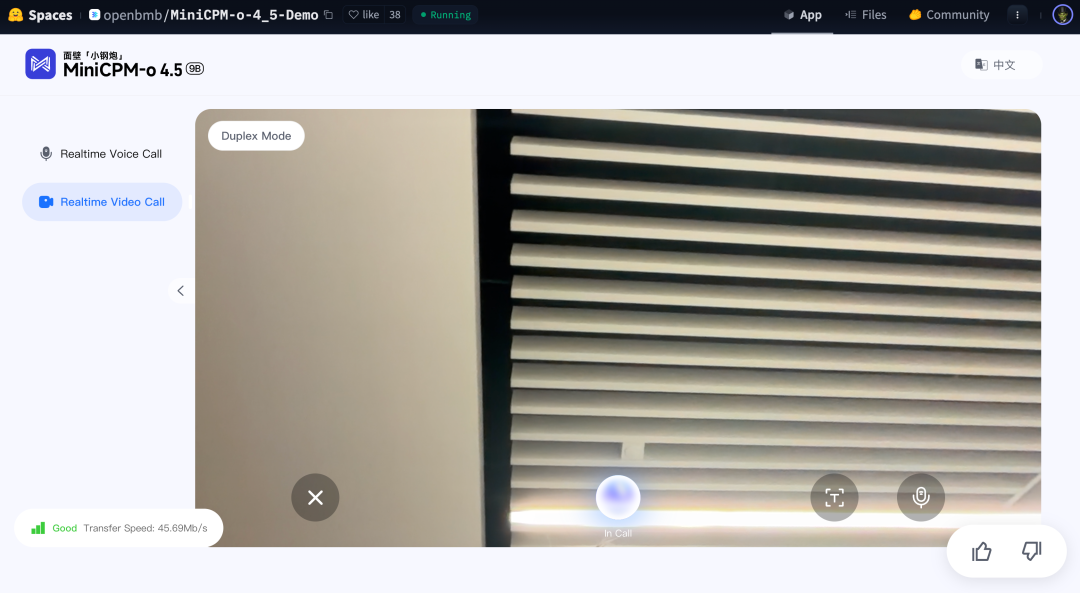

快速体验

最便捷的方式是使用Hugging Face官方Demo(支持语音和摄像头交互):

- 地址:https://huggingface.co/spaces/openbmb/MiniCPM-o-4_5-Demo

- 无需本地部署,浏览器直接使用

本地部署方案

官方提供了完整的开源部署工具链,适配多种场景:

- llama.cpp-omni:面壁自研的流式全模态推理框架,主打端侧/边缘设备低延迟,原生支持全双工

- 主流推理框架适配:vLLM、SGLang、Ollama、LLaMA-Factory等

- 量化模型方案:

- 原始bf16:约19GB显存

- int4量化:内存降至11GB或更低,推理速度超200 tokens/s

- 国产芯片适配:已通过FlagOS系统栈适配天数智芯、华为昇腾、平头哥、海光、沐曦等,对国产硬件的AI应用落地有实际意义

硬件需求参考

- 消费级GPU单卡即可满足推理需求(特别是int4量化后)

- 支持在手机、车机、平板等端侧设备运行

- 实现了"本地化+隐私+低延迟"的部署目标

四、应用场景分析

基于其技术特征,MiniCPM-o 4.5比较适合的应用场景包括:

- 实时视频分析:监控、安防、直播内容理解等(高效的视频处理能力)

- 语音交互设备:车机系统、智能音箱、机器人等(全双工交互更接近自然对话)

- 端侧隐私应用:医疗、金融等对数据隐私有要求的场景(本地运行,不上传)

- 受限算力环境:边缘计算、IoT设备、离线场景(参数量小、推理快)

- 国产芯片生态:已适配国产处理器的企业应用

五、相似项目参考

如果你对多模态端侧方案感兴趣,可以关注这些相关项目:

- MiniCPM-V系列:MiniCPM-o 4.5的视觉模块基于同系列的设计,在图像理解上也有出色表现

- Gemini 2.5 Flash(闭源):官方对标方案,但仅云端可用

- 其他端侧多模态模型:如LLaVA系列、LLaMA-VID等,但在全双工语音交互上没有同等支持

六、总体评价

MiniCPM-o 4.5在当前的开源多模态生态中,确实填补了一个有价值的位置:它不仅是"参数小",更重要的是设计理念从一开始就是为端侧服务。与其说它是"GPT-4o的平替",不如说它是一个不同价值定位的方案——用更少的参数、更低的延迟、更强的隐私保护来换取接近但不完全相同的能力。

从产品经理的角度看,这个项目有几个值得关注的特点:

- 对技术栈的选择很务实:没有堆砌参数,而是在规定的约束条件下做最优化

- 部署友好程度超预期:官方提供了完整的工具链和国产芯片适配,降低了社区使用的门槛

- 社区热度反映的是真实需求:Hugging Face热榜第2不是偶然,反映出端侧AI能力的确有市场需求

- 商业化潜力清晰:已有完整的开源方案和国产生态适配,企业落地的成熟度相对较高

如果你的团队在考虑部署多模态AI应用,特别是在端侧设备上实现实时交互的场景,MiniCPM-o 4.5是一个值得纳入技术选型的方案。

开源地址:https://github.com/OpenBMB/MiniCPM-o

Hugging Face:https://huggingface.co/openbmb/MiniCPM-o-4_5