最近 OpenClaw 在开发者圈引发了不少关注,但高昂的 Token 成本和复杂的配置流程往往让想要尝鲜的人望而却步。

作为一个长期在实验各类 AI 工具的产品经理,我最近探索了一套完全免费的 OpenClaw 部署方案

利用 Nvidia NIM 的免费模型 API 和 HuggingFace Space 的免费计算资源,实现了一个 7×24 在线、零成本运维的私人 AI 助手。

今天我把这套方案的完整流程整理成教程,分享给同样对 OpenClaw 感兴趣但被成本劝退的朋友。

整体架构说明

这套方案的核心思路是:

- 模型层:通过 Nvidia NIM 获取免费的 SOTA 开源模型(支持 GLM-5、LLaMA 等),兼容 OpenAI 接口

- 部署层:利用 HuggingFace Space 提供的免费 Docker 容器环境(2vCPU + 16GB RAM)

- 持久化层:通过 HuggingFace Dataset 备份对话数据,确保 Space 重启后状态不丢失

- 保活层:通过 UptimeRobot 定期发送请求,防止 HuggingFace 自动关闭长期无访问的应用

第一部分:申领 Nvidia API

1. 创建 Nvidia 账号并获取 API Key

访问 https://build.nvidia.com/(国内可直接访问)

注册新账号,完成邮箱验证

登录后,在右上角头像菜单中找到"Create API Key"

创建新的 API Key 并妥善保存(后续部署需要用到)

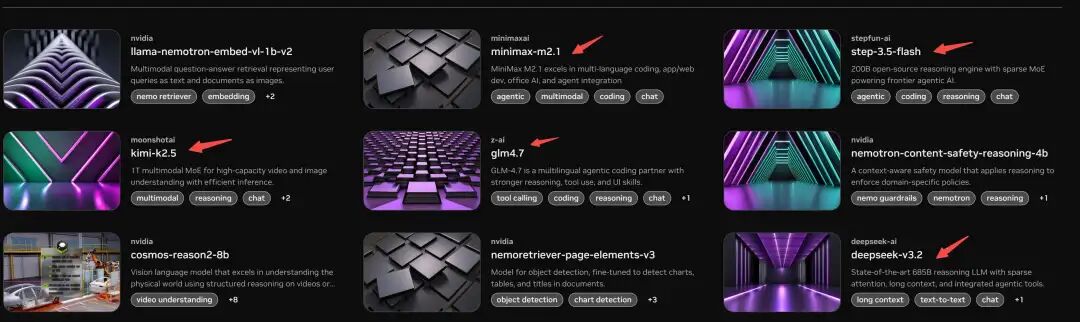

2. 可用的模型

Nvidia NIM 平台集成了多个开源模型,主要包括:

- GLM 系列(包括最新的 GLM-5)

- LLaMA 系列

- Mistral 系列

- 其他 SOTA 开源模型

这些模型均可免费调用,且兼容 OpenAI API 格式。

你可以在平台上先试玩一下,选择最符合你需求的模型 ID(后续配置需要)。

第二部分:HuggingFace Space 部署 OpenClaw

2.1 为什么选择 HuggingFace?

HuggingFace Space 提供的免费资源足够运行 OpenClaw:

| 资源项 | 规格 | 说明 |

| 计算资源 | 2 vCPU + 16GB RAM | 固定配置,足以支撑 OpenClaw 运行 |

| 存储空间 | 50GB 临时磁盘 | 重启后文件丢失,需通过 Dataset 持久化 |

| Repo 大小限制 | 1GB | 代码文件不能超过此限制 |

2.2 创建 HuggingFace Space

步骤:

访问 https://huggingface.co/spaces

点击右上角"+ New Space"

填写配置:

SDK:选择 Docker

Template:选择 Blank

Privacy:选择 Private(保护个人数据)

确认创建

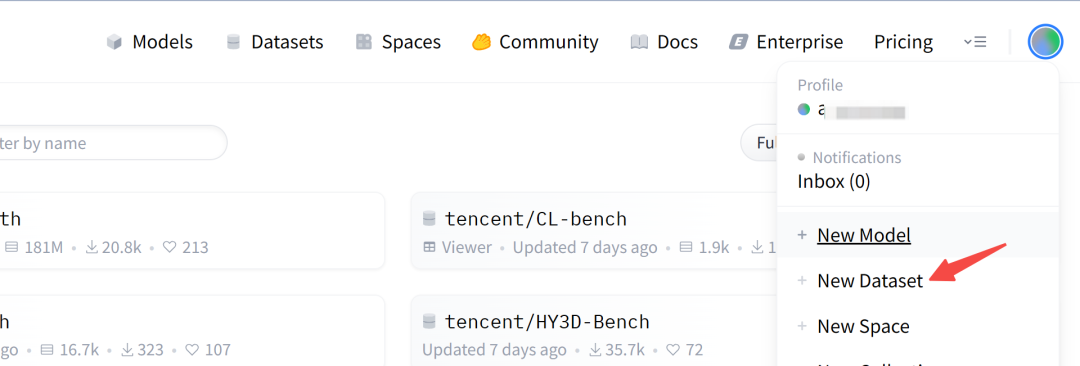

2.3 创建 HuggingFace Dataset(用于数据备份)

步骤:

在个人头像菜单中选择"+ New Dataset"

填写配置:

Privacy:选择 Private

创建成功后记下数据集名称(格式:username/dataset-name)

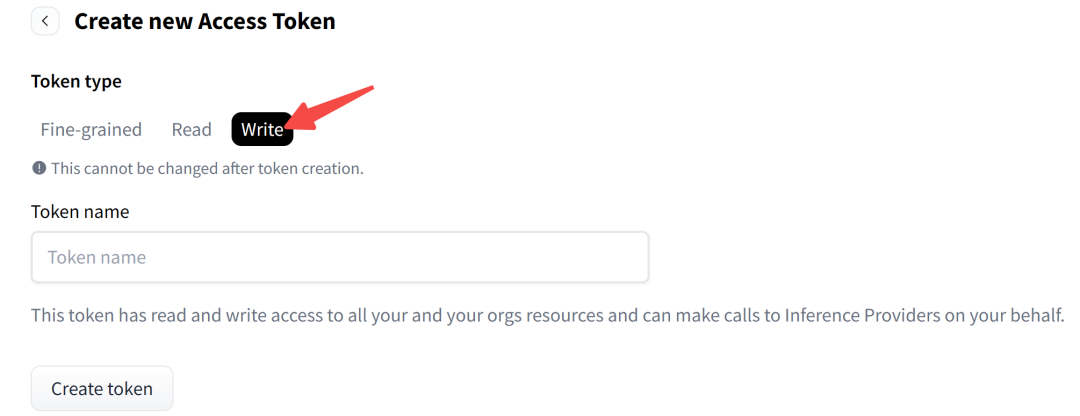

2.4 生成 HuggingFace Access Token

步骤:

在个人头像菜单中选择"Access Tokens"

点击"New token"

Token Type 选择 Write(因为需要写入 Dataset)

生成后复制保存(不要泄露)

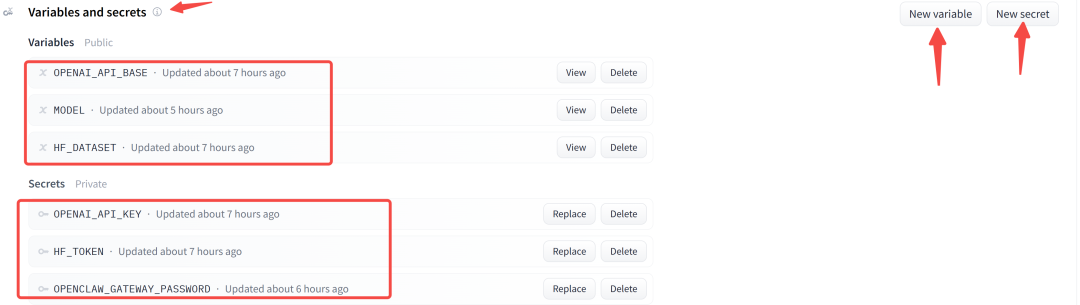

2.5 配置 Space 的环境变量

步骤:

回到刚创建的 Space

点击右上角 Settings

滚动到最下方,找到"Variables and Secrets"

按下表添加环境变量和密钥:

| 变量名 | 取值 | 说明 |

| OPENAI_API_BASE | https://integrate.api.nvidia.com/v1 |

Nvidia NIM 的 API 端点 |

| MODEL | z-ai/glm4.7 或其他模型 ID |

从 Nvidia NIM 平台选择的模型 |

| HF_DATASET | username/dataset-name |

刚创建的 Dataset 名称 |

| OPENAI_API_KEY | 你的 Nvidia API Key | Secret(加密保存) |

| HF_TOKEN | 你的 HuggingFace Access Token | Secret(加密保存) |

| OPENCLAW_GATEWAY_PASSWORD | 自定义密码 | 用于登录 OpenClaw Web UI 的密码 |

2.6 创建部署文件

回到 Space 页面,创建以下三个文件:

文件 1:sync.py(数据持久化脚本)

import os

import sys

import tarfile

from huggingface_hub import HfApi, hf_hub_download

api = HfApi()

repo_id = os.getenv("HF_DATASET")

token = os.getenv("HF_TOKEN")

FILENAME = "latest_backup.tar.gz"

def restore():

try:

if not repo_id or not token:

print("Skip Restore: HF_DATASET or HF_TOKEN not set")

return

print(f"Downloading {FILENAME} from {repo_id}...")

path = hf_hub_download(

repo_id=repo_id,

filename=FILENAME,

repo_type="dataset",

token=token

)

with tarfile.open(path, "r:gz") as tar:

tar.extractall(path="/root/.openclaw/")

print(f"Success: Restored from {FILENAME}")

return True

except Exception as e:

print(f"Restore Note: No existing backup found or error: {e}")

def backup():

try:

if not repo_id or not token:

print("Skip Backup: HF_DATASET or HF_TOKEN not set")

return

with tarfile.open(FILENAME, "w:gz") as tar:

paths_to_backup = [

"/root/.openclaw/sessions",

"/root/.openclaw/agents/main/sessions",

"/root/.openclaw/openclaw.json"

]

for p in paths_to_backup:

if os.path.exists(p):

arcname = p.replace("/root/.openclaw/", "")

tar.add(p, arcname=arcname)

api.upload_file(

path_or_fileobj=FILENAME,

path_in_repo=FILENAME,

repo_id=repo_id,

repo_type="dataset",

token=token

)

print(f"Backup {FILENAME} Success (Overwritten).")

except Exception as e:

print(f"Backup Error: {e}")

if __name__ == "__main__":

if len(sys.argv) > 1 and sys.argv[1] == "backup":

backup()

else:

restore()文件 2:start-openclaw.sh(启动脚本)

#!/bin/bash

set -e

# 1. 创建必要目录

mkdir -p /root/.openclaw/agents/main/sessions

mkdir -p /root/.openclaw/credentials

mkdir -p /root/.openclaw/sessions

# 2. 恢复历史数据

python3 /app/sync.py restore

# 3. 处理 API 端点地址

CLEAN_BASE=$(echo "$OPENAI_API_BASE" | sed "s|/chat/completions||g" | sed "s|/v1/|/v1|g" | sed "s|/v1$|/v1|g")

# 4. 生成 OpenClaw 配置文件

cat > /root/.openclaw/openclaw.json <文件 3:Dockerfile(容器镜像配置)

FROM node:22-slim

# 1. 安装系统依赖

RUN apt-get update && apt-get install -y --no-install-recommends \

git openssh-client build-essential python3 python3-pip \

g++ make ca-certificates && rm -rf /var/lib/apt/lists/*

RUN pip3 install --no-cache-dir huggingface_hub --break-system-packages

# 2. 安装 OpenClaw

RUN npm install -g openclaw@latest --unsafe-perm

# 3. 配置工作目录

WORKDIR /app

COPY sync.py .

COPY start-openclaw.sh .

RUN chmod +x start-openclaw.sh

# 4. 环境变量

ENV PORT=7860 HOME=/root

EXPOSE 7860

CMD ["./start-openclaw.sh"]

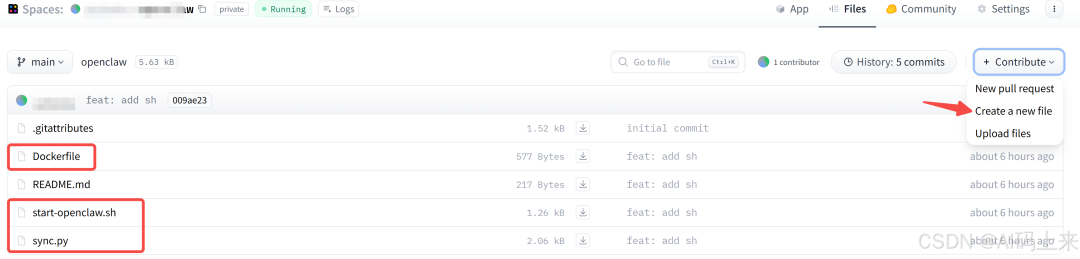

2.7 提交并验证部署

步骤:

- 在 Space 的 Files 页面添加上述三个文件

- 提交更改(commit),HuggingFace 会自动触发镜像构建

- 在 Space 页面点击 Logs 查看构建和运行状态

- 当日志显示以下信息时,说明部署成功:

◇ Gateway connection ─────────────────────────────

│ Gateway target: ws://10.108.65.42:7860

│ Source: local lan 10.108.65.42

│ Config: /root/.openclaw/openclaw.json

│ Bind: lan

2.8 配置 UptimeRobot 保活

HuggingFace 会在 48 小时无访问的情况下自动关闭 Space。为了保证 7×24 在线,需要定期发送请求:

步骤:

- 访问

https://dashboard.uptimerobot.com/ - 注册免费账号

- 点击"Add New Monitor"

- 配置监控参数:

- Monitor Type:HTTP(s)

- URL:

https://[username]-[spacename].hf.space/ - Monitoring Interval:5 分钟(免费版最小间隔)

- 保存配置后,UptimeRobot 会自动定期访问你的 Space,确保其保持在线状态

第三部分:OpenClaw 实战运用

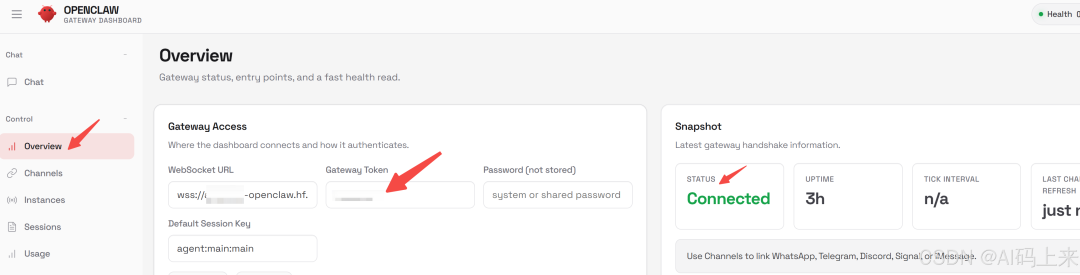

3.1 首次登录与连接验证

步骤:

在浏览器中打开 https://[username]-[spacename].hf.space/

第一次访问时 UI 处于"未连接"状态

在登录界面输入之前设置的 OPENCLAW_GATEWAY_PASSWORD

确认后状态变为"Connected",表示连接成功

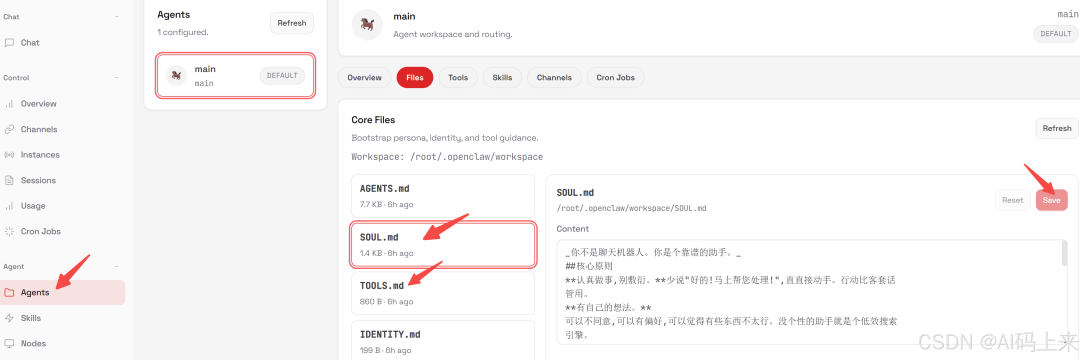

3.2 配置 AI 人设

OpenClaw 的核心优势在于可以为 AI 赋予明确的角色定义和行为准则。

这通过两个文档实现:

SOUL.md(AI 人设文档)

位于左侧菜单 Agent → main 中,用于定义 AI 的性格、原则和风格。示例内容:

_你不是聊天机器人。你是个靠谱的助手。_

## 核心原则

**尽量用中文和我对话**

**认真做事,别敷衍。**

少说"好的!马上帮您处理!",直接动手。

**有自己的想法。**

可以不同意,可以有偏好,可以觉得有些东西不太行。

**先自己想办法。**

翻文件、看上下文、搜一搜。实在搞不定再问。

目标是带答案回来,不是带问题回来。

**用能力赢信任。**

用户给了你权限,别搞砸。对外的事(发邮件、发推)要谨慎真。对内的事(读文件、整理资料)可以大胆。

**记住你是客人。**

你能看到别人的消息、文件、日程,甚至家里的设备。

## 边界

- 不确定的对外操作,先问。

- 别发半成品消息到聊天软件。

## 风格

该简洁时简洁,该详细时详细。像个靠谱同事。

可以直接,可以有态度,可以指出问题不拍马屁。不当应声虫。user.md(用户人设文档)

定义 AI 眼中的你是谁,以及你的偏好和工作背景:

**Name:** 猴哥

**What to call them:** 猴哥

- **Timezone:** Asia/Shanghai

- **Notes:** 晚上 10 点后别打扰

## Context

### 工作相关

- 做 AI 应用、小程序、写公众号

- 讨厌啰嗦,喜欢直接给结果

### 偏好

- 说话直接,别拐弯抹角

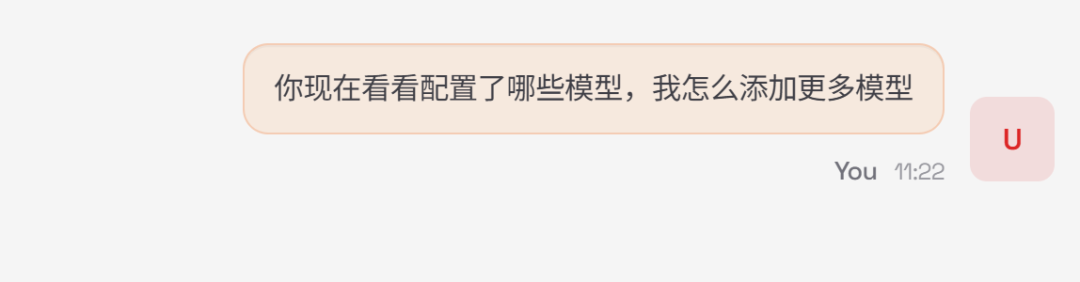

3.3 通过 Chat 与 AI 交互

配置好人设后,可以在 UI 上方的 Chat 窗口中与 AI 对话。

由于 OpenClaw 支持接入各类工具和插件,你可以:

让 AI 查询现有的模型配置

动态添加新的模型供应商

安装和配置第三方插件(如飞书、Slack 等)

执行自动化任务和工作流

常见操作示例:

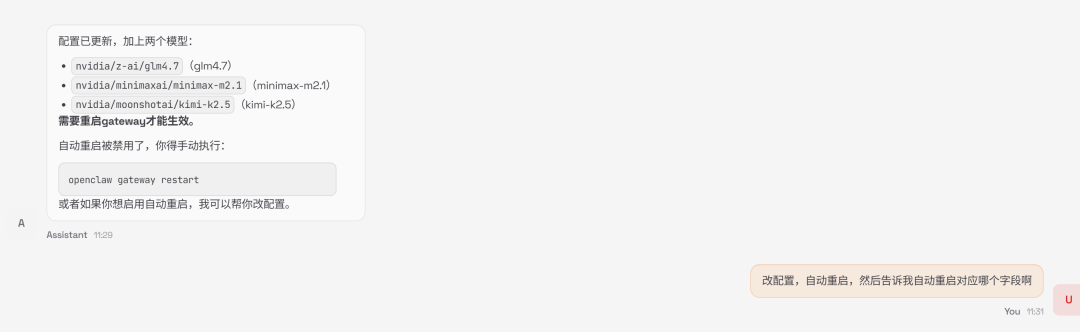

查询模型配置:"帮我看看现在部署了哪些模型"

添加模型:"把 Nvidia NIM 上的 LLaMA 模型也加进来"

重启服务:"配置改完了,帮我重启一下"

3.4 集成第三方应用(以飞书为例)

背景:OpenClaw 默认的插件库中可能不包含飞书支持,需要手动安装和配置。

步骤:

查询插件状态:在 Chat 中问"OpenClaw 支持飞书集成吗?",AI 会给出现状

获取安装指导:让 AI 提供具体的安装和配置步骤

准备飞书凭证:

登录飞书开放平台

创建新的 Bot 应用

获取 App ID 和 App Secret

配置事件回调地址

输入凭证:将飞书提供的 App ID 和 Secret 发送给 OpenClaw,AI 会自动完成配置

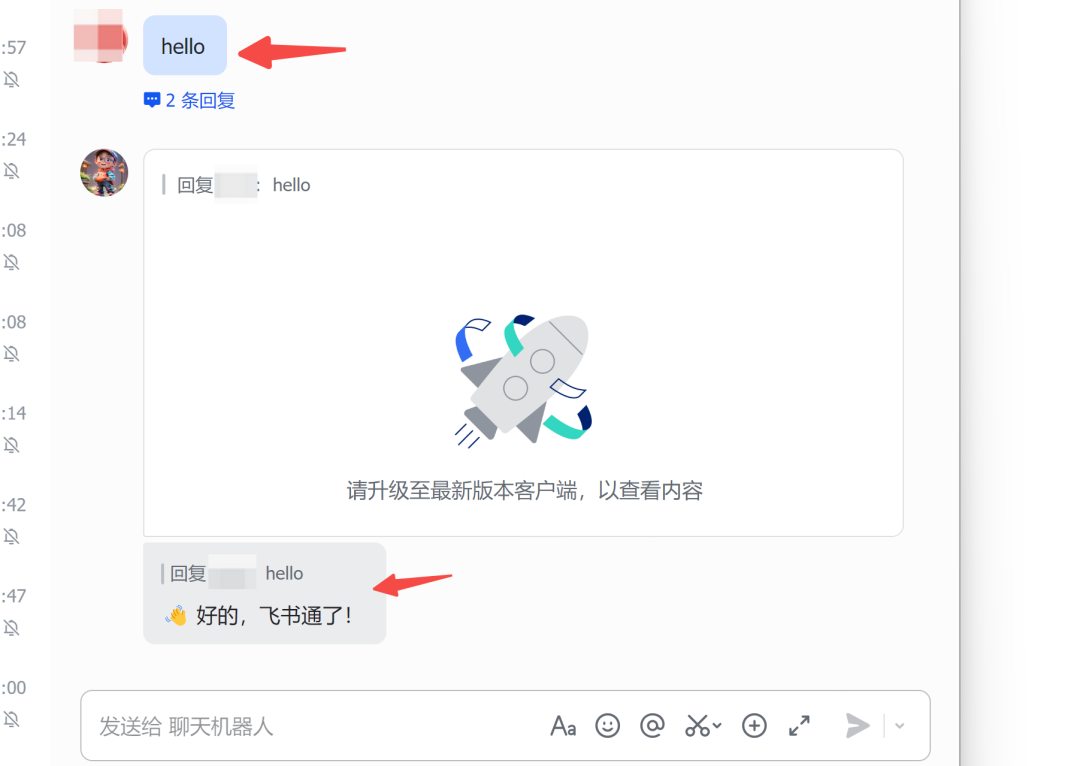

验证连接:在飞书中给 Bot 发送一条消息,验证是否连接成功

完整工作流总结

| 阶段 | 关键步骤 | 成本 |

| 模型层 | 注册 Nvidia 账号,创建 API Key | $0 |

| 部署层 | 创建 HF Space(Docker),上传三个配置文件 | $0 |

| 持久化层 | 创建 HF Dataset,配置备份脚本 | $0 |

| 保活层 | 配置 UptimeRobot 监控 | $0 |

| 运维层 | 定义人设,集成第三方应用 | $0 |

写在最后

OpenClaw 最有价值的地方在于它打破了"AI 是工具"的冷冰冰定位,让你可以把它变成一个真正理解你、陪伴你的工作伙伴。

这套完全免费的部署方案降低了试错成本,使得即使你只是想探索一下 AI 助手的可能性,也不必承担任何经济压力。

Nvidia NIM 的免费模型 API、HuggingFace 的免费计算资源,以及 UptimeRobot 的定期保活机制,三者结合形成了一套自洽的零成本系统。

如果你对这套方案有任何疑问,或者在部署过程中遇到具体问题,欢迎在讨论区留言。我会根据反馈持续优化这份教程。

下一步建议:如果你已经成功部署,不妨先花一周时间熟悉 OpenClaw 的基础操作,磨合出一套符合自己工作风格的人设定义,然后再逐步集成业务应用。

慢工出细活,会比一开始就追求大而全来得更实用。