在处理多个大语言模型(LLM)供应商的集成时,我发现大多数开发者面临一个共同的痛点:需要维护多套不同格式的 API 接口、担心单点故障、手动统计 Token 消耗和成本。最近体验了一个开源项目 Octopus,它以简洁高效的设计思路,将这些分散的问题统一处理,值得关注。

项目概览

Octopus 是一款为个人开发者和企业团队设计的 LLM API 聚合与负载均衡服务。

核心定位是降低多渠道 LLM 接入的复杂度,通过统一接口管理、智能路由分发和成本追踪,减少开发和运维的负担。

核心功能梳理

1. 多渠道聚合管理

支持接入 OpenAI、Anthropic、Gemini 等多个主流 LLM 供应商,统一通过 Web 管理面板进行配置。

具体特性包括:

- 自动补全 API 路径,用户仅需填写基础 URL

- 协议自动互转(OpenAI Chat、OpenAI Responses、Anthropic 三种格式互通)

- 无需修改业务代码,新增渠道即时生效

2. 分组与负载均衡

将多个渠道聚合为统一的模型分组,支持四种负载均衡策略:

| 策略 | 说明 |

| 轮询 | 依次分配请求到各渠道,适合等权重场景 |

| 随机 | 随机选择渠道,降低热点压力 |

| 故障转移 | 优先调用高优先级渠道,故障时自动降级 |

| 加权分配 | 按自定义权重比例分配流量 |

这种设计避免了单渠道依赖风险,提高了服务可用性和吞吐能力。

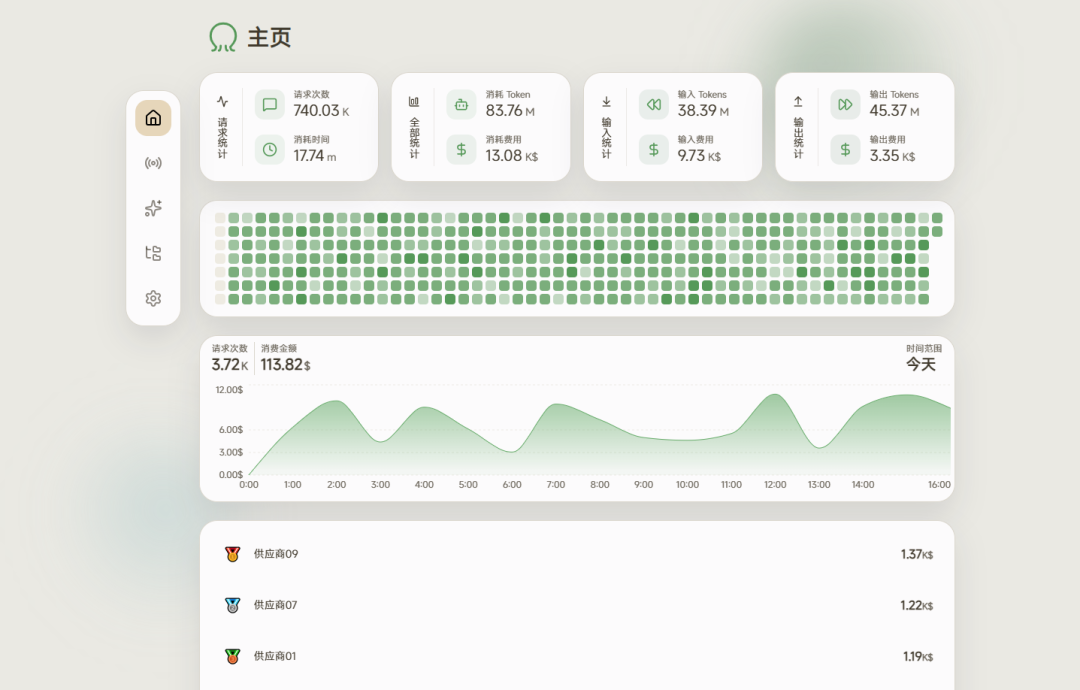

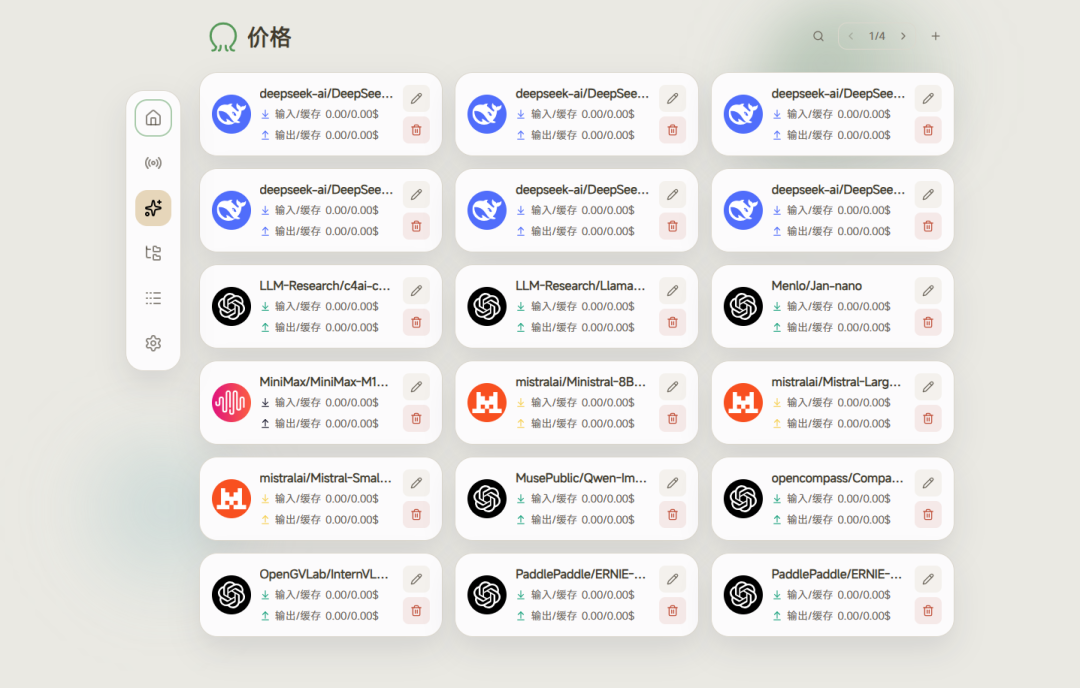

3. 价格与费用追踪

核心在于透明的成本管理:

- 自动同步:定期从 models.dev 获取最新模型价格数据

- 自定义覆盖:支持手动设置模型价格,优先级高于自动同步

- 精细统计:记录每次请求的 Token 消耗和实时费用,可视化展示

- 数据持久化:内存缓存 + 周期性批量写入数据库,兼顾性能与安全

4. 多数据库适配

根据部署规模灵活选择:

- SQLite:默认配置,零依赖,适合个人开发和小规模部署

- MySQL/PostgreSQL:支持企业级部署,需预先创建数据库

所有配置项均可通过环境变量(OCTOPUS_ 前缀)覆盖,灵活适配不同运维场景。

5. Web 管理面板

提供桌面端和移动端适配的管理界面,模块设计清晰:

- 首页:整体概览

- 渠道管理:添加/编辑 LLM 供应商配置

- 分组管理:创建模型分组与负载均衡策略

- 价格管理:同步和自定义模型价格

- 日志查询:请求历史与费用明细

- 系统设置:账户、数据库、监听地址等配置

部署方案对比

| 部署方式 | 适用场景 | 操作步骤 |

| Docker | 快速启动、容器化环境 | docker run -d --name octopus -v /path/to/data:/app/data -p 8080:8080 bestrui/octopus (推荐) |

| 二进制文件 | 无容器依赖、轻量部署 | 下载 Release 版本,直接运行 ./octopus start |

| 源码编译 | 自定义开发、参与贡献 | 需 Go 1.24.4+ 和 Node.js 18+,前后端分离构建 |

首次部署建议:使用 Docker Compose 或二进制文件。启动后访问 http://localhost:8080,默认账户为 admin/admin,首次登录务必修改密码。

应用场景分析

个人开发者:对接多个 LLM 进行模型选型和功能测试,避免被单一供应商的 API 变化影响开发流程。

初创公司/小团队:搭建轻量级 AI 服务网关,实现基础的负载均衡和成本控制,无需复杂的基础设施。

企业级应用:在生产环境中汇聚多个 LLM 供应商,降低服务中断风险,精确追踪 AI 相关成本。

相关项目推荐

如果你在寻找类似功能的方案,可考虑对比:

- LiteLLM:Python 库,提供统一 API 接口,学习曲线更陡但集成灵活性强

- Ollama:本地 LLM 部署工具,侧重于开源模型运行,功能与 Octopus 不重合

- FastGPT:知识库 + LLM 的完整应用框架,功能范围更广但部署复杂度更高

Octopus 的差异化在于:专注 API 网关层、部署简洁、开箱即用的成本追踪,定位更精准。

总结

从产品经理的角度,Octopus 解决了一个真实且高频的痛点:多个 LLM 供应商的接入和管理。

它通过统一接口、智能路由、自动成本追踪等功能,降低了技术集成的复杂度。

代码开源、部署灵活、界面友好,这些特点使得它既适合个人项目验证,也能支撑小规模企业应用。

如果你正在构建涉及多个 LLM 的应用,或考虑为团队搭建 API 网关层,这个项目值得试用。

相比自己从零开发路由和成本统计逻辑,使用现成的开源方案可以节省不少时间。