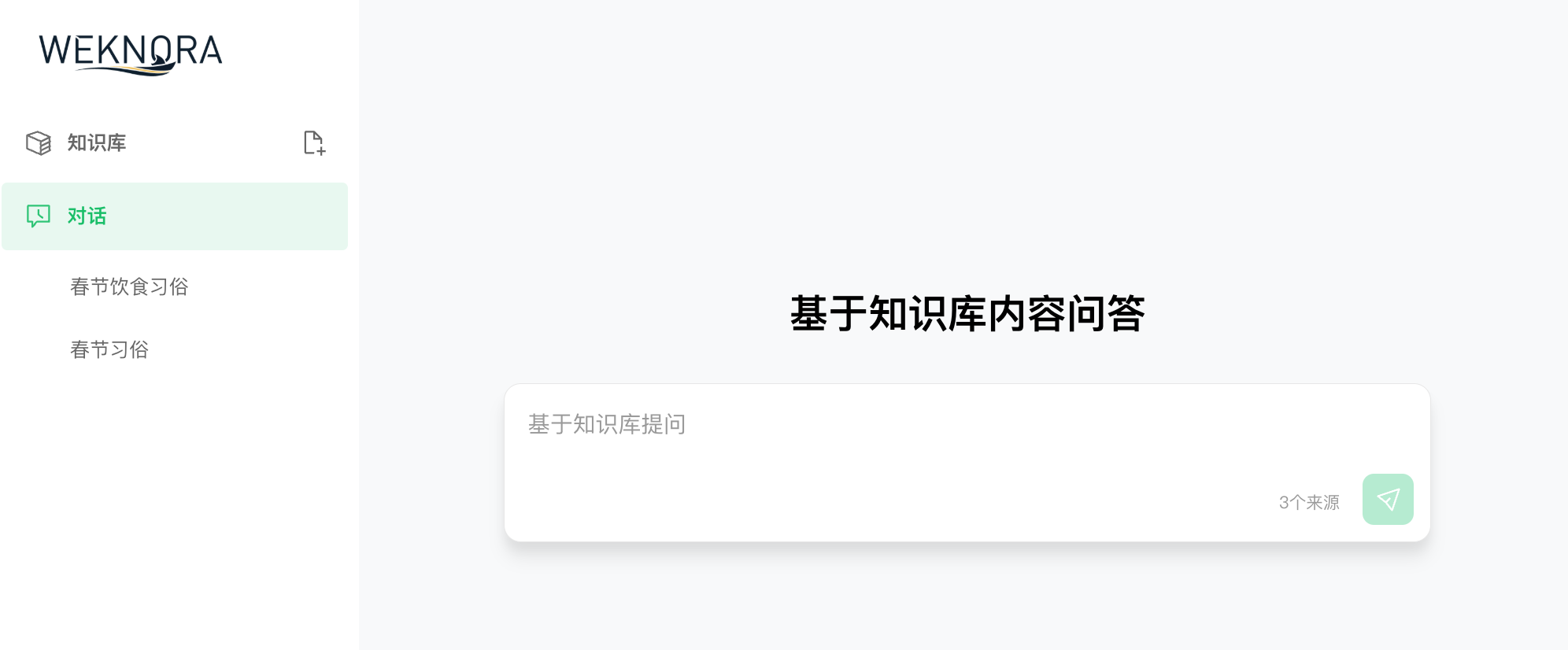

WeKnora,感觉挺有意思,值得专门写篇文章聊聊。

简单来说,它就是 一个基于大模型的文档理解与检索框架,可以看作是腾讯内部 ima 知识库应用的开源版。

之前用过 ima,体验还行,但最大的问题是:没有 API。

每次想更新知识库,都得手动加资料,完全无法自动化,也没法和工作流结合。

而 WeKnora 的出现,算是补上了这个短板:不仅能本地部署,还开放了完整 API,能无缝对接智能体、自动化脚本,实用性一下子拉满。

项目介绍

WeKnora(维娜拉) 是腾讯开源的一款 文档理解与语义检索框架,核心思路是基于 RAG(Retrieval-Augmented Generation)机制,把文档拆解成语义片段,再结合大语言模型进行问答。

它特别适合面对复杂、异构的文档场景,比如 PDF、Word、Markdown,甚至图文混排的 OCR 资料,都能被解析和检索。

功能亮点

我简单总结了一下 WeKnora 的核心特性:

-

精准理解:支持多种文档格式解析,能提取结构化内容

-

智能问答:结合大语言模型,支持上下文感知和多轮对话

-

灵活扩展:解析、嵌入、召回、生成全流程模块化,可自由替换

-

高效检索:支持关键词、向量、知识图谱混合检索

-

简单易用:有直观的 Web 界面,也提供标准化 API

-

数据可控:支持本地化部署,企业内部知识库完全自有

换句话说,WeKnora 既能当一个“离线版 ChatGPT 知识库”,也能作为企业级智能检索底座。

部署体验

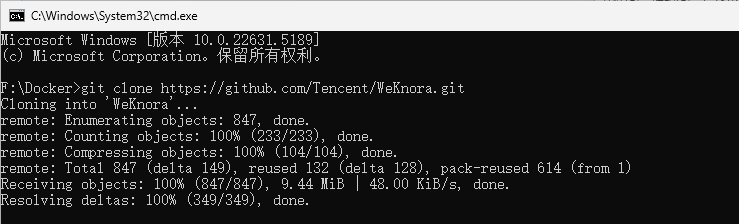

我在本地用 Docker 跑了一下,大概步骤如下:

git clone https://github.com/Tencent/WeKnora.git

cd WeKnora

把Weknora下载下来,也可以直接下载包

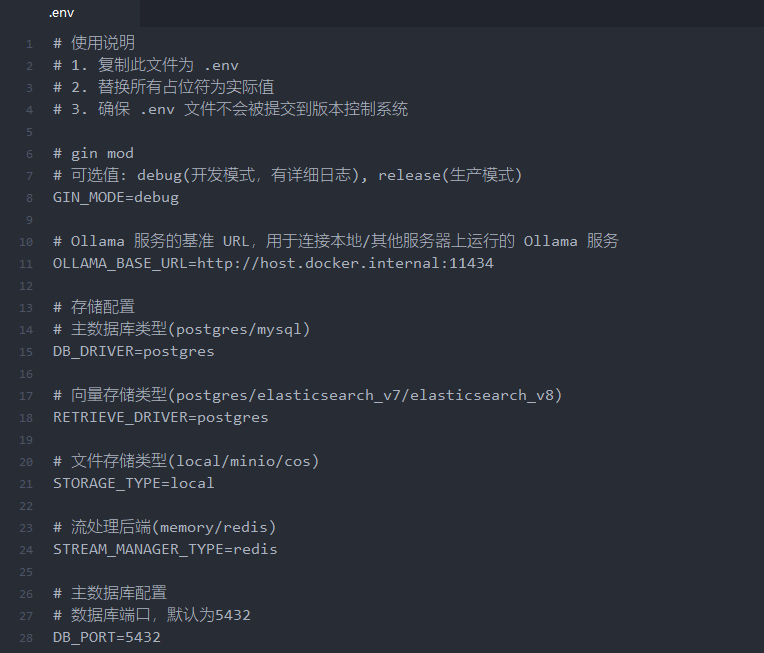

接着修改配置

# 复制配置文件

copy .env.example .env

修改.env里的配置,支持调用本地大模型

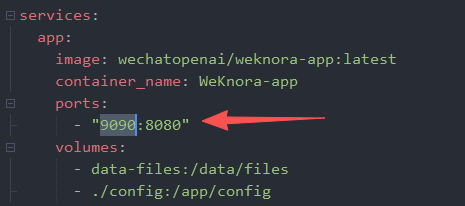

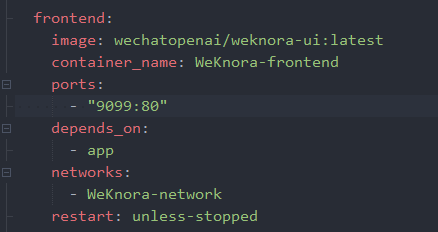

编辑docker-compose.yml的配置文件。如果本地的端口有占用的情况

需要将下面几个端口修改下:

运行docker,拉取WeKnora进行安装

docker compose up -d

启动后,在浏览器输入 http://localhost:设置的端口 就能进入配置界面。

接下来可以设置:

LLM 模型:支持 Ollama 本地部署,也能接入 Remote API(如 Qwen、DeepSeek)

Embedding 模型:Embedding嵌入模型是将文本,图像等数据转换成向量,这个向量能捕捉到对象的核心特征和语义信息,是知识库中的关键因素。

多模态 & Rerank 配置:可以进一步微调检索效果

整体安装和配置还算顺畅,不需要太多折腾。

使用场景

我觉得 WeKnora 的适用场景非常广,特别是对企业和科研人员:

-

企业知识管理:规章制度、内部文档检索

-

科研文献分析:论文、研究报告整理

-

产品技术支持:产品手册、技术 FAQ、故障排查

-

法律合规审查:合同条款、法规政策检索

-

医疗辅助:医学文献、诊疗指南查询

以前需要人工翻文档,现在可以直接问答式调用,效率差别很大。

API 能力

这部分是我最喜欢的,也是最推荐的用法,因为后续希望接入n8n或dify这类工作流使用,那API是少不了的。

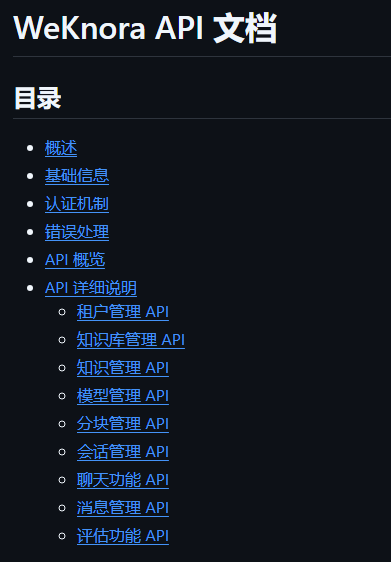

WeKnora 提供了 9 类 API,覆盖知识库的创建、更新、删除、查询等操作。

这意味着——我完全可以把文档的更新、检索和问答,接入现有的工作流或智能体系统,真正实现“自动更新 + 智能检索”,看看这详细的API接口使用文档:

对比之前的 ima,这个简直就是生产力质变。

技术细节速览

-

文档支持:PDF / Word / Txt / Markdown(含 OCR 图文混排)

-

嵌入模型:支持本地 & API 模式(BGE / GTE / 阿里云等)

-

数据库:PostgreSQL + pgvector,或 Elasticsearch

-

检索机制:BM25 / Dense / GraphRAG

-

大模型集成:支持 Qwen、DeepSeek、本地 LLM

-

交互方式:Web UI + RESTful API

-

部署方式:本地 & Docker,支持私有化

从技术栈看,WeKnora 的定位很明确:既要面向企业级场景,又要保持足够的开放性和灵活性。

谁最适合用 WeKnora?

-

想搭建 企业私有知识库 的 IT 团队

-

想把文档检索接入 智能体/自动化工作流 的开发者

-

有严格数据合规需求的 金融、医疗、法律机构

-

想要一款比 ChatGPT 更可控的 本地知识库工具 的个人开发者

我的感受总结

作为一个经常测试 AI 工具的产品经理,我觉得 WeKnora 的出现挺有意义:

-

终于把腾讯内部的知识库能力开源出来了

-

API 的加持让它更像是一个“底层工具”,而不是“封闭应用”

-

本地部署、数据自控,对企业来说是个刚需

如果你之前被 ima 限制 API 的问题困扰过,那 WeKnora 基本能满足你对“自动化知识库”的所有想象。

我个人已经把它接入到自己的一些工作流测试里,下一步打算试试看和智能体结合,做一个“自我更新的本地知识助理”。

最后一句:

WeKnora 是一款非常实用的开源知识库框架,适合想要可控、可扩展、能自动化的用户。 如果你正好需要搭建企业内部知识库,不妨试试它。

项目地址:

官网:https://weknora.weixin.qq.com

GitHub:https://github.com/Tencent/WeKnora

API 文档: