在如今AI爆发的时代,越来越多的企业与开发者依赖OpenAI、Anthropic或Claude等云端服务,但这些服务往往价格高昂、需要联网、还存在数据安全隐患。有没有一种方式,让我们可以完全离线运行强大的多模态AI模型,甚至兼容OpenAI的API?

答案就是——LocalAI。

这款由 Ettore Di Giacinto 创建并开源的项目,是一个完全免费的开源OpenAI替代方案。

LocalAI支持在本地或私有服务器上运行文本、图像、音频乃至视频生成模型,无需任何GPU,普通消费级硬件即可运行。

这意味着,企业可以用它搭建起自己的AI服务,个人开发者也能在离线环境下玩转AI模型。

LocalAI是什么?

LocalAI是一个与OpenAI API兼容的自托管REST API框架,支持OpenAI、Anthropic、ElevenLabs等API规范,且可以直接替换它们的API调用。

只需修改几行代码,所有依赖OpenAI接口的应用,便可以无缝迁移到本地部署版本。

它不仅能进行大模型的文本生成,还支持多模态AI功能:

- 文本生成(基于GPT类模型)

- 图片生成(使用Stable Diffusion或Diffusers)

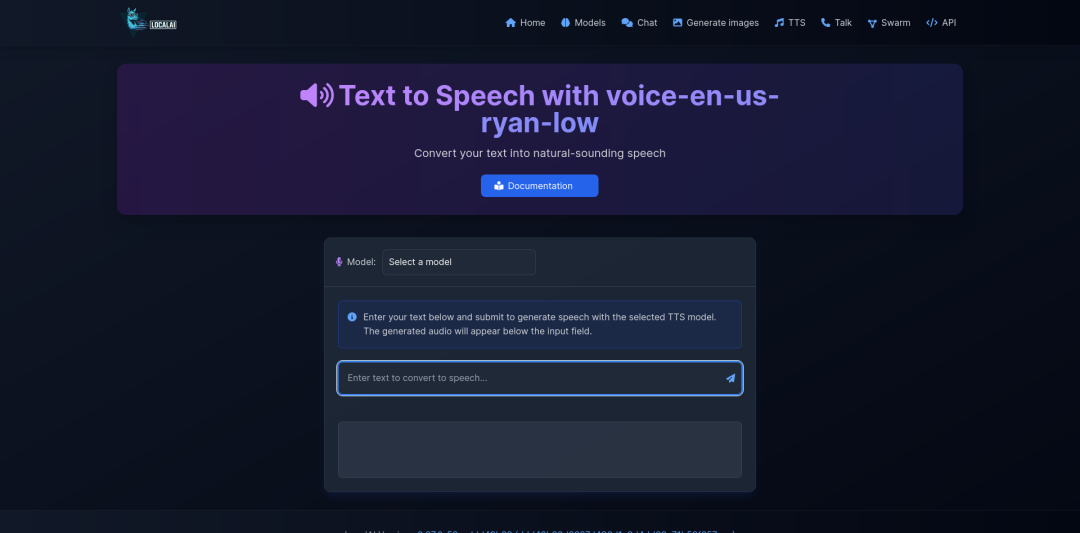

- 语音合成与识别(Whisper、Bark等后端)

- Embeddings向量生成

- 语音克隆与音频生成

- P2P分布式推理(支持AI Swarm模式)

- 内置WebUI图形界面

- 完全兼容OpenAI SDK与多种语言接口(如Python、LangChain等)

它能够运行的模型家族也相当丰富:

- 支持

gguf、transformers、diffusers等格式; - 兼容 Huggingface、Ollama、Docker Hub 中的模型;

- 自动检测GPU类型并使用最佳后端加速。

Local Stack 家族

LocalAI并非孤立存在,它已经发展为一个本地AI生态套件。

目前包括:

| 名称 | 简介 |

|---|---|

| LocalAGI | 本地智能体(AGI)管理平台,可直接替代OpenAI Responses API,并加入更多智能代理能力。 |

| LocalRecall | 提供持久化记忆与知识库功能的RESTful API,为AI代理提供“长期记忆”。 |

这两者与LocalAI无缝协同,可构建出具备长期记忆+多代理决策的本地人工智能系统。

快速上手

LocalAI安装相当简便,无论你是macOS、Linux还是Windows用户,都可以几分钟内启动。

一键安装命令:

curl https://localai.io/install.sh | sh

或者使用Docker运行:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest

这样,你就可以通过 http://localhost:8080 访问完整的Web管理界面。

LocalAI还提供不同硬件的镜像版本:

- CPU专用镜像(无需GPU)

- NVIDIA GPU版本(CUDA 11/12)

- AMD、Intel、Apple Metal、Vulkan加速镜像

更令人惊喜的是,它还提供 “AIO(All-In-One)镜像”,包含预下载模型,无需额外配置。

模型与后端支持

LocalAI支持目前几乎所有主流AI后端。

文本与语言模型:

llama.cpp、vLLM、transformers、exllama2、MLX

支持NVIDIA、AMD、Intel乃至Apple芯片。

语音与音频处理:

whisper.cpp(语音识别)bark/coqui/kokoro(TTS)neutts(语音克隆)silero-vad(语音活动检测)

图像与视频生成:

stablediffusion.cppdiffusers(包括SDXL和SANA)

特殊任务支持:

rfdetr(实时目标检测)rerankers(文档重排器)local-store(本地向量数据库)

不论你使用什么硬件,LocalAI都能自动选择最优加速方案。例如在Apple M架构下,使用Metal与MLX后端自动加速;在NVIDIA显卡上,则启用CUDA路径。

分布式与P2P

从2024年开始,LocalAI引入了去中心化P2P推理模式。每一台运行LocalAI的节点都可以成为全网推理集群的一部分,这意味着:

- 你能让多台电脑协同加速AI推理;

- 或加入全球的LocalAI社区计算池;

- AI模型可在你的私有网络中共享与协作。

P2P面板中还能直观看到所有节点状态与负载情况。

模型加载示例

加载模型同样非常直观:

# 从模型库安装

local-ai run llama-3.2-1b-instruct:q4_k_m

# 从Huggingface运行模型

local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf

# 从Ollama注册表中安装模型

local-ai run ollama://gemma:2b

LocalAI会自动检测当前系统支持的GPU类型,并在后台下载合适的后端驱动,无需人工配置。

本地AI开发的必备利器

LocalAI不仅提供API兼容性,还拥有面向开发者的丰富生态:

- LangChain集成:轻松在私有环境中构建RAG检索问答系统

- Slack / Discord / Telegram机器人示例

- VSCode插件:本地编码AI助手

- Home Assistant集成:打造家庭智能语音管家

- Kubernetes & Helm Chart支持:可快速扩展为企业级部署方案

项目近期动态

- 2025年10月 — 增加 Model Context Protocol (MCP),支持AI代理调用外部工具

- 2025年8月 — 支持Mac M系列MLX与VLM模型

- 2025年7月 — 引入Object Detection对象检测API与rf-detr模型

- 2025年4月 — WebUI重构,视觉交互全面升级

- 2024年5月 — 实现P2P分布式推理和联邦计算

适用场景

- 企业私有部署AI服务(如智能客服、知识问答、语音机器人)

- AI研究与模型测试(学习不同架构模型的表现)

- 个人开发者离线应用(无网络环境下的自动化助手)

- 教育与内部培训(安全、可控的数据环境)

与同类项目比较

| 项目 | 特点 | 是否开源 | 是否需GPU |

|---|---|---|---|

| LocalAI | 完全兼容OpenAI API、本地运行、多模态支持、去中心化P2P | ✅ 是 | ❌ 否 |

| Ollama | 桌面轻量部署,专注文本LLM | ✅ 是 | ❌ 否 |

| LM Studio | 图形界面友好,适合个人AIGC使用 | ❌ 否 | ❌ 否 |

| Text Generation WebUI | 强大但开发导向高 | ✅ 是 | 🔧 可选 |

| vLLM / llama.cpp | 底层推理库 | ✅ 是 | 🔧 可选 |

LocalAI的独特之处在于它不仅兼容多种模型与API,还能实现语音、图像、视频等多模态处理,真正做到了“AI全能本地引擎”。