作为一名经常接触各类AI应用的产品经理,我发现了一个在数据获取环节特别高频的痛点:如何高效地将网页内容转化为LLM可直接使用的格式。

传统爬虫方案往往需要针对不同网站编写解析代码,还要额外处理JavaScript渲染、反爬虫机制等技术细节。

最近体验的开源项目Firecrawl在这个方向给出了一套相当实用的解决方案,已经积累了69.9K Star,值得重点关注。

项目概览

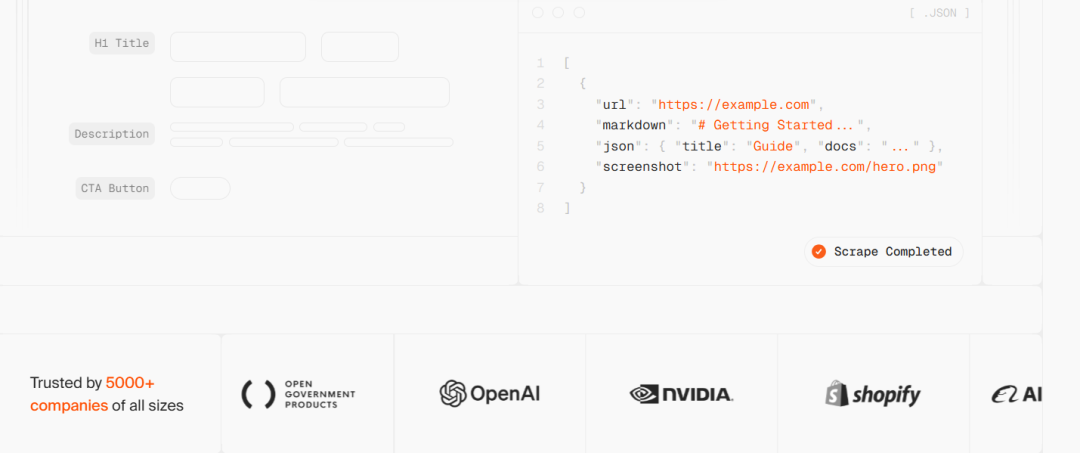

Firecrawl是一个专为AI应用设计的网页数据抓取API服务,核心价值在于将任意网页自动转换成LLM可直接使用的Markdown或结构化JSON数据。

相比传统爬虫库(如BeautifulSoup、Scrapy),它的差异化主要体现在:

- LLM友好的输出格式:直接生成干净的Markdown、结构化JSON、截图等,无需额外的数据清洗和解析代码

- 自动化的技术难点处理:内置代理轮换、JS渲染、反爬虫识别等能力,使用者无需关注底层实现

- 灵活的部署方式:提供云端API服务和开源自托管两种选项

项目使用TypeScript + Python开发,遵循AGPL-3.0开源协议。

核心功能解析

1. 基础网页抓取

单页面抓取是最基础的使用场景。通过简单的API调用,可获取页面的Markdown、HTML或截图:

curl -X POST https://api.firecrawl.dev/v2/scrape \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer YOUR_API_KEY' \

-d '{

"url": "https://docs.firecrawl.dev",

"formats": ["markdown", "html"]

}'相比直接使用HTTP库和解析库,这种API方式消除了对HTML结构理解的依赖,特别适合需要快速接入数据的AI应用。

2. 整站爬取

输入域名后,Firecrawl会自动发现并爬取所有子页面,无需预先准备sitemap文件:

curl -X POST https://api.firecrawl.dev/v2/crawl \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer YOUR_API_KEY' \

-d '{

"url": "https://docs.firecrawl.dev",

"limit": 10,

"scrapeOptions": {

"formats": ["markdown", "html"]

}

}'返回任务ID后,可异步查询爬取结果,支持大规模批量处理(数千个URL)。这一特性特别适合构建垂直领域的知识库或进行竞品分析。

3. LLM结构化数据提取

这是Firecrawl相比传统爬虫最有竞争力的地方。支持两种提取方式:

方式一:Schema-based提取(定义严格的数据结构)

curl -X POST https://api.firecrawl.dev/v2/scrape \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer YOUR_API_KEY' \

-d '{

"url": "https://www.mendable.ai/",

"formats": [

{

"type": "json",

"schema": {

"type": "object",

"properties": {

"company_mission": {"type": "string"},

"is_open_source": {"type": "boolean"},

"is_in_yc": {"type": "boolean"}

}

}

}

]

}'方式二:自然语言提取(用Prompt描述需求)

curl -X POST https://api.firecrawl.dev/v2/scrape \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer YOUR_API_KEY' \

-d '{

"url": "https://docs.firecrawl.dev/",

"formats": [

{

"type": "json",

"prompt": "Extract the company mission from the page."

}

]

}'这两种模式允许用户根据业务需求灵活选择,特别适合RAG(检索增强生成)系统和AI数据处理流程。

4. 网页搜索和交互

除了爬取已知URL,Firecrawl还支持:

- 互联网搜索:比标准搜索API强大,直接返回完整网页内容

- 页面交互(云端专属):支持点击、输入、滚动等操作,可抓取动态加载的内容

- 变更监控:持续监测页面内容更新

5. SDK支持

提供Python和Node.js官方SDK,降低集成成本:

Python示例:

from firecrawl import Firecrawl

from pydantic import BaseModel, Field

from typing import List

firecrawl = Firecrawl(api_key="fc-YOUR_API_KEY")

# 基础抓取

doc = firecrawl.scrape(

"https://firecrawl.dev",

formats=["markdown", "html"]

)

# 整站爬取

response = firecrawl.crawl(

"https://firecrawl.dev",

limit=100,

scrape_options={"formats": ["markdown", "html"]}

)

# 结构化提取(使用Pydantic模型)

class Article(BaseModel):

title: str

points: int

class TopArticles(BaseModel):

articles: List[Article] = Field(..., description="Top 5 stories")

doc = firecrawl.scrape(

"https://news.ycombinator.com",

formats=[{"type": "json", "schema": TopArticles}]

)Node.js示例:

import Firecrawl from '@mendable/firecrawl-js';

const firecrawl = new Firecrawl({ apiKey: 'fc-YOUR_API_KEY' });

// 基础抓取

const doc = await firecrawl.scrape('https://firecrawl.dev', {

formats: ['markdown', 'html']

});

// 整站爬取

const response = await firecrawl.crawl('https://firecrawl.dev', {

limit: 100,

scrapeOptions: { formats: ['markdown', 'html'] }

});部署方案对比

| 维度 | 云端服务 | 开源自托管 |

|---|---|---|

| 部署难度 | 无需部署,注册获取API Key即可使用 | 需自行搭建基础设施,有一定学习成本 |

| 成本 | 按量付费,初期免费额度 | 服务器和带宽成本,但长期成本可能更低 |

| 功能支持 | 完整支持,包括页面交互、搜索等 | 核心爬取功能,部分高级功能受限 |

| 隐私控制 | 数据通过第三方服务器 | 完全私有部署,数据不离开本地 |

| 适用场景 | 快速原型、中小规模应用 | 大规模商用、对隐私有要求、高并发场景 |

生态集成

Firecrawl已与主流AI框架和低代码平台实现无缝对接:

- LLM框架:LangChain、LlamaIndex、Crew.ai、Composio

- 低代码平台:Dify、Langflow、Flowise

- 自动化工具:Zapier、Pipedream

这意味着用户可以快速将Firecrawl集成到现有的AI工作流中,而无需编写过多胶水代码。

典型应用场景

1. RAG系统的数据管道

用Firecrawl抓取网页内容并转换为Markdown,直接喂入向量数据库,构建私有知识库:

- 文档库构建(技术文档、产品说明)

- 新闻聚合系统

- 竞品监控系统

2. 数据分析和挖掘

使用整站爬取和结构化提取能力,快速收集特定格式的数据:

- 电商平台商品信息抓取

- 招聘网站职位数据收集

- 房产信息聚合

3. AI代理和自动化流程

结合页面交互能力,支持更复杂的自动化任务:

- 表单填充和提交

- 动态内容抓取(如加载更多)

- 跨网站数据同步

与同类项目的对比

| 项目 | 定位 | 优势 | 劣势 |

|---|---|---|---|

| Firecrawl | AI应用专用网页抓取 | LLM友好、自动化程度高、SDK完善 | 云端服务有成本,自托管文档相对欠缺 |

| Scrapy | 通用爬虫框架 | 功能全面、性能高、生态成熟 | 学习曲线陡峭,需要编写大量代码 |

| Beautiful Soup | HTML解析库 | 轻量级、易上手 | 仅做HTML解析,需配合其他库使用 |

| Playwright | 浏览器自动化 | 支持复杂交互和JS渲染 | 资源消耗大,不针对数据格式处理 |

相比之下,Firecrawl的差异化在于它专注于AI应用的数据需求,提供了从爬取到结构化提取的完整链路,使得AI开发者无需在数据预处理上投入过多精力。

安装与快速开始

最快上手方案(云端服务)

- 访问官网 https://firecrawl.dev 并注册账户

- 获取API Key

- 使用cURL或SDK调用API

自托管部署

项目GitHub仓库提供了Docker Compose配置,用户可通过以下步骤部署:

# 克隆仓库

git clone https://github.com/firecrawl/firecrawl.git

cd firecrawl

# 配置环境变量

cp .env.example .env

# 使用Docker Compose启动

docker-compose up总结

从产品经理的角度看,Firecrawl的推出反映了当前AI应用在数据获取层面的迫切需求。

它不是在重新发明爬虫技术,而是改变了开发者与网页数据之间的交互方式——从"我需要写代码去解析HTML"转变为"我直接告诉系统我需要什么数据"。