Ollama 官宣支持接入 ClaudeCode,现在可以在本地使用自己的模型了

刚好看到 Ollama 官宣支持 Anthropic API 接入,意味着可以用本地模型对接 ClaudeCode 做编程辅助。

- Ollama 增加了 Anthropic API 兼容能力,ClaudeCode 可以通过本地端口访问 Ollama 提供的模型,实现“本地推理 + ClaudeCode 工作流”。

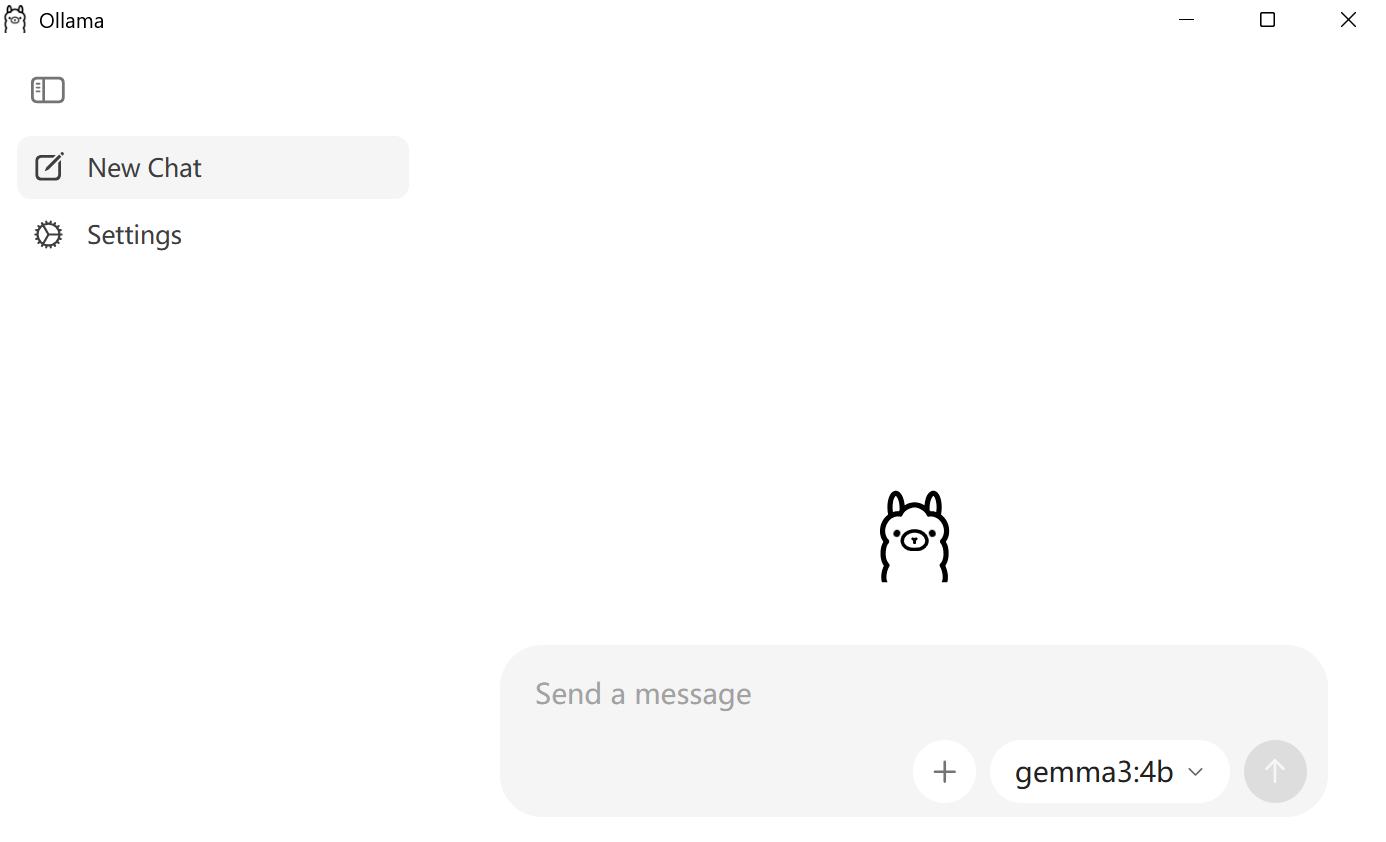

- 安装后的 Ollama 自带 GUI,可视化配置模型与参数,并可自定义模型存储路径,解决了早期默认挤占 C 盘空间的问题。

- 接入步骤简单,主要是设置环境变量与模型选择;但在主流笔记本配置下,本地中大型模型的响应速度与稳定性逊于云端服务,团队场景更适合云厂商提供的编程套餐。

配置方法

目标是让 ClaudeCode 把请求发到本地的 Ollama 服务,由 Ollama 调用选定的本地模型完成代码生成或补全。

安装/更新 Ollama:建议升级到最新版。打开自带 GUI,在 Settings 中设置模型存储路径(避免挤占系统盘),并按需下载模型。

启动 Ollama 服务并确认端口:默认本地服务在 http://localhost:11434。

设置环境变量:让 ClaudeCode 走本地的 Anthropic 兼容端点。

- Linux/macOS:

export ANTHROPIC_AUTH_TOKEN=ollama export ANTHROPIC_BASE_URL=http://localhost:11434 - Windows PowerShell:

$env:ANTRHOPIC_AUTH_TOKEN = "ollama" $env:ANTHROPIC_BASE_URL = "http://localhost:11434"

如果需要在多套配置间切换,可以用第三方工具(如 CCSwitch)管理环境变量与端点。

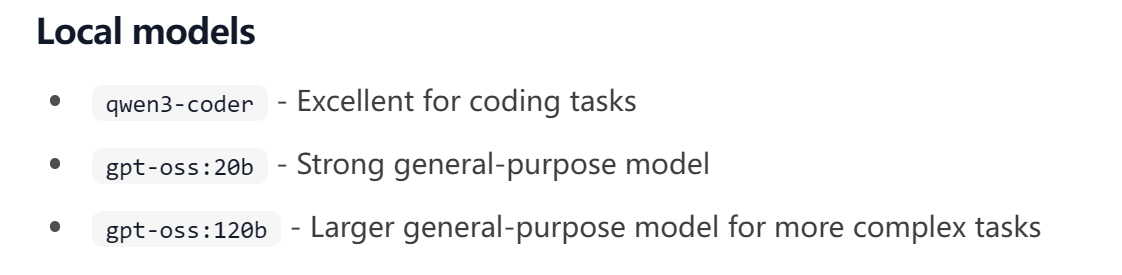

在 ClaudeCode 指定模型:官方文档列出几款适合本地编程任务的模型,示例:

claude --model gpt-oss:20b

具体模型名称与兼容性以文档为准,建议先从体量较小、启动更快的模型试用,再逐步上探到更大参数量。

官方建议是使用下面三个模型用于本地编程任务。

本地 vs 云端的差异化

功能范围:

本地(Ollama):可选多种开源/社区模型,满足基础代码补全、注释、简单重构,依赖本机算力。

云端(MiniMax M2.1、GLM-4.7、等):模型规模与指令对齐更充分,通常在复杂重构、长上下文、跨语言迁移上更稳定。

技术特征:

本地:无外网依赖,更好的隐私与可控性;需要处理模型体积、显存/内存占用、CPU/GPU兼容。

云端:推理性能与可用性更一致,支持更完整的生态(如 MCP 扩展、检索、视觉),版本迭代快。

使用门槛:

本地:安装与环境变量配置较直接,但要考虑端口冲突、代理设置、模型下载路径管理。

云端:开通账号与密钥后即可使用,几乎无本地运维成本。

适合人群:

本地:对隐私敏感的个人/小团队、希望离线或内网环境使用的研发人员。

云端:需要稳定产出与复杂任务支持的专业开发者或团队,强调协作与服务等级保障。

使用中的注意点

- 模型体积与硬件:中大型模型占用显存/内存较高,普通轻薄本跑起来会明显慢;可先选较小模型验证流程。

- 路径与存储:在 Ollama 的 Settings 中自定义模型路径,避免默认盘满;定期清理不常用模型。

- 端口与代理:确保 11434 无冲突;如使用公司代理,需在 ClaudeCode 与系统网络设置中一致配置。

- 兼容性:不同模型对指令格式与代码任务的适配程度不同,遇到补全不稳定时,换模型通常能改善体验。

结语

Ollama 接入 Anthropic API,让“本地模型 + ClaudeCode”的组合变得更顺手:安装简单、图形化配置、路径可控,对个人开发者是一次实用增强。

但选择本地还是云端,核心仍在适配性,硬件条件、任务复杂度与协作方式决定了最合适的方案。

我的建议是先用小模型打通流程,再按需求升级模型或切换到云端,避免一开始就背负不必要的复杂度。