作为长期评测 AI 开发工具的产品经理,我对“AI 写代码”这类产品向来谨慎。多数工具能快速生成片段,但难以在真实项目里长期稳定地协作。

过去一段时间我在两个持续迭代的代码库里用 OpenCode 做了多轮试用,最大的感受是:OpenCode不在于“能不能写”,而在于“如何把 AI 放进工程流程”,让它和需求、版本、上下文、规范共同运转。

这一点,与我们熟悉的对话式 Copilot 有本质区别。

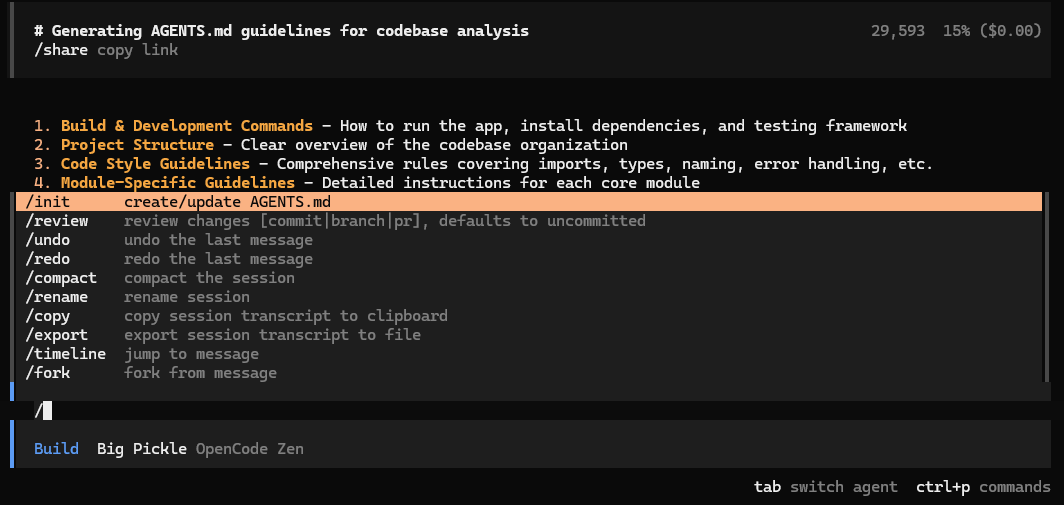

核心观点

OpenCode是一个开源、模型解耦的编程智能体系统,强调工程可控性与可审计性,不是单纯的“代码生成器”。

它用“Plan/Build 双模式”“多 Agent 多会话”“LSP 自动加载”等机制,把需求澄清、设计权衡、修改执行拆分到可管理的步骤。

与 Claude Code、Cursor 等产品相比,OpenCode的差异在“控制权”和“扩展性”:模型自由切换、私有化部署、可与团队规范深度绑定。

一、OpenCode 是什么

结论先行:OpenCode 是一个 100% 开源、与模型完全解耦的 AI 编程智能体系统,既提供 CLI,也提供桌面端与 Web 界面,定位是“把 AI 拉进工程体系的基础设施”。

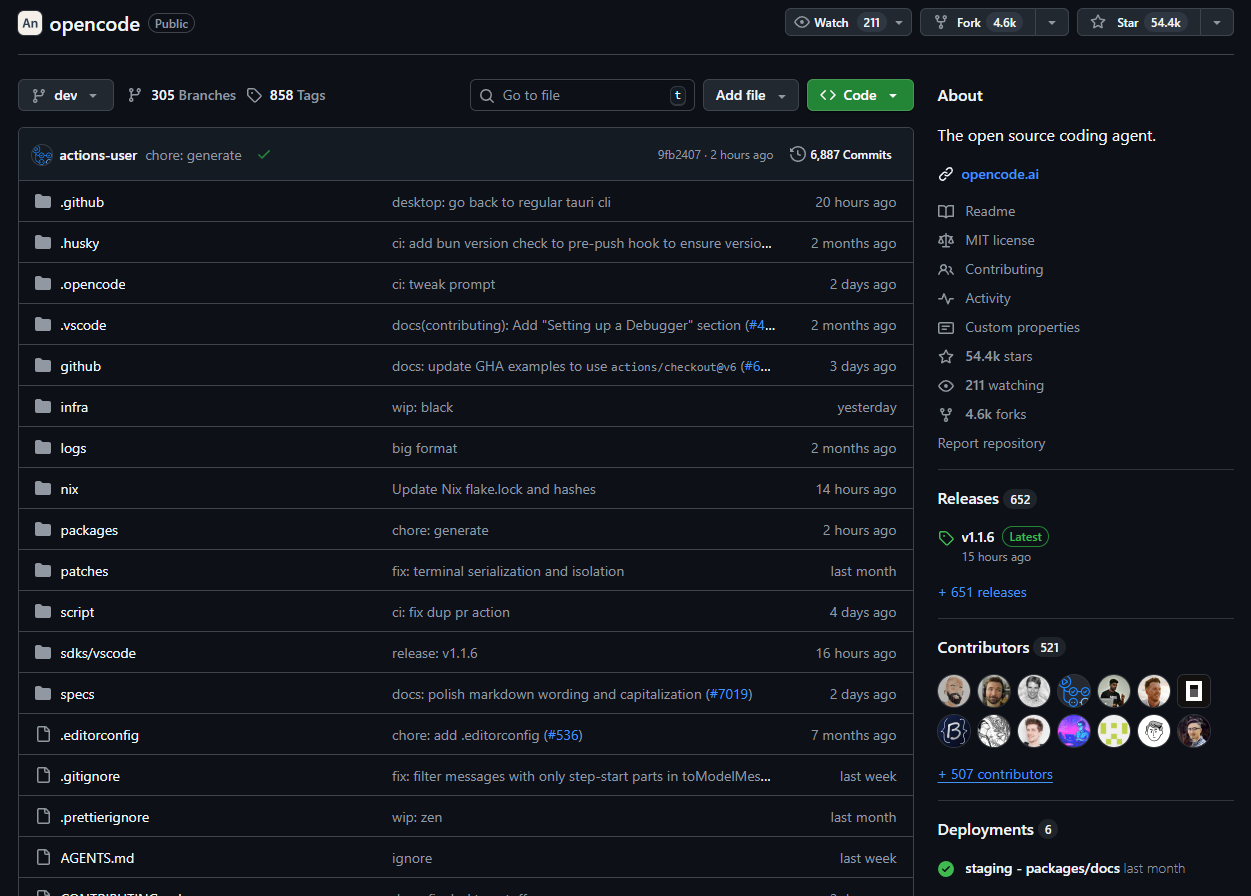

项目地址:https://github.com/anomalyco/opencode

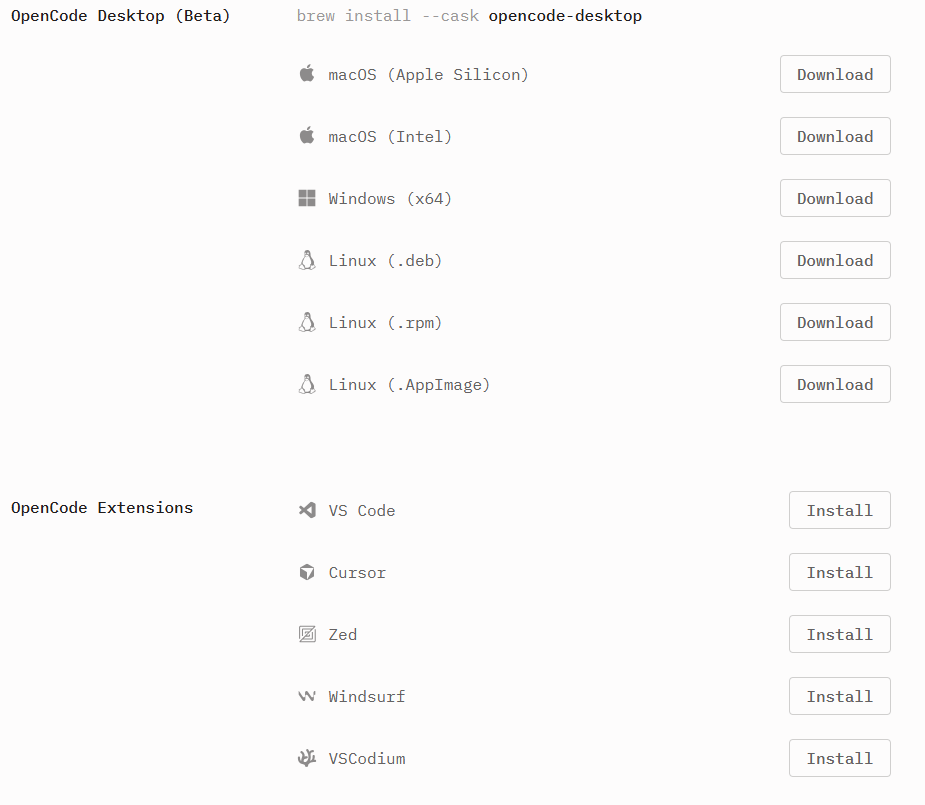

形态:CLI + Web UI + 桌面端(Beta)+ IDE 插件

模型:可切换使用 OpenAI、Anthropic、Google Gemini、DeepSeek、Groq、Together、Fireworks、OpenRouter,以及本地模型(Ollama / LM Studio / llama.cpp 等),官方宣称支持 75+ Provider

使用场景:需求澄清、跨文件分析、重构、排错、测试生成、文档同步、CI 辅助等

社区侧的数据(以仓库公开信息为准)显示其增长稳定,并且贡献者基数较大,意味着它不是“演示级”工具,而是在真实工程场景中被持续打磨的系统。

价格与授权

- 软件授权:开源免费(以仓库 LICENSE 文件为准)。

- 使用成本:不绑定任何单一模型,按你连接的模型提供商计费;使用本地模型时仅有本地算力成本。

- 托管与企业化:可私有部署,支持服务端/客户端分离,适合在受控网络或合规环境使用。

系统与环境要求(概览)

操作系统:macOS、Windows、Linux(x86_64 / arm64 均可)

安装方式:脚本安装、Homebrew、Chocolatey/Scoop、npm 全局安装、Docker

本地模型:建议 16GB+ 内存;GPU/CPU 要求视具体模型而定(Ollama/llama.cpp 等)

二、为什么它“看起来像 Claude Code”,但本质不同

OpenCode 与 Claude Code 的交互观感确实接近,但核心差异在“控制权、扩展性与部署方式”。

| 维度 | OpenCode | Claude Code | Cursor(对照) |

|---|---|---|---|

| 产品形态 | 开源 CLI/桌面/Web/插件,可私有化 | 商业产品,集成在 Claude 生态 | 商业 IDE(基于 VS Code),深度改造 |

| 模型绑定 | 完全解耦,75+ Provider 与本地模型 | 以 Anthropic 模型为主 | 多模型支持,但策略上以托管为主 |

| 工程可控性 | Prompt/Context/Agent 可配置、版本化;Plan/Build 分离 | 产品内置流程,配置空间相对有限 | 工程能力强,基于 IDE 工作流,但闭源 |

| 团队协作 | 多 Agent 多会话、Skills、MCP 接入外部系统 | 与 Claude 项目/Artifacts 配合 | 团队功能依赖许可,偏 IDE 内协作 |

| 部署与数据 | 本地/服务器运行;可控日志与密钥存储 | 云端为主,桌面端加强数据隔离 | 本地 IDE + 云服务混合 |

| 学习门槛 | 需要理解 Agent/Plan/Build/MCP/Skills | 较低,上手快 | IDE 用户上手快,深度配置有门槛 |

| 成本可控性 | 自选模型与路由,成本策略可细化 | 以 Anthropic 定价为准 | 订阅 + 模型使用 |

归纳:Claude Code 注重“开箱即用的一体化体验”,OpenCode 强调“工程化可控与可扩展”。选择取决于你是否要将 AI 深度嵌入自有的工程规范、环境与合规边界。

三、OpenCode 的关键能力

LSP 自动加载

OpenCode 内置 LSP(Language Server Protocol)集成,能自动为项目语言装配 LSP Server(如 bash-language-server、clangd、csharp、clojure-lsp、dart 等),从而:

-

- 识别项目语言与依赖图

- 具备语法/类型/引用级理解,而非“靠猜”

- 在生成修改前有更准确的上下文抓取

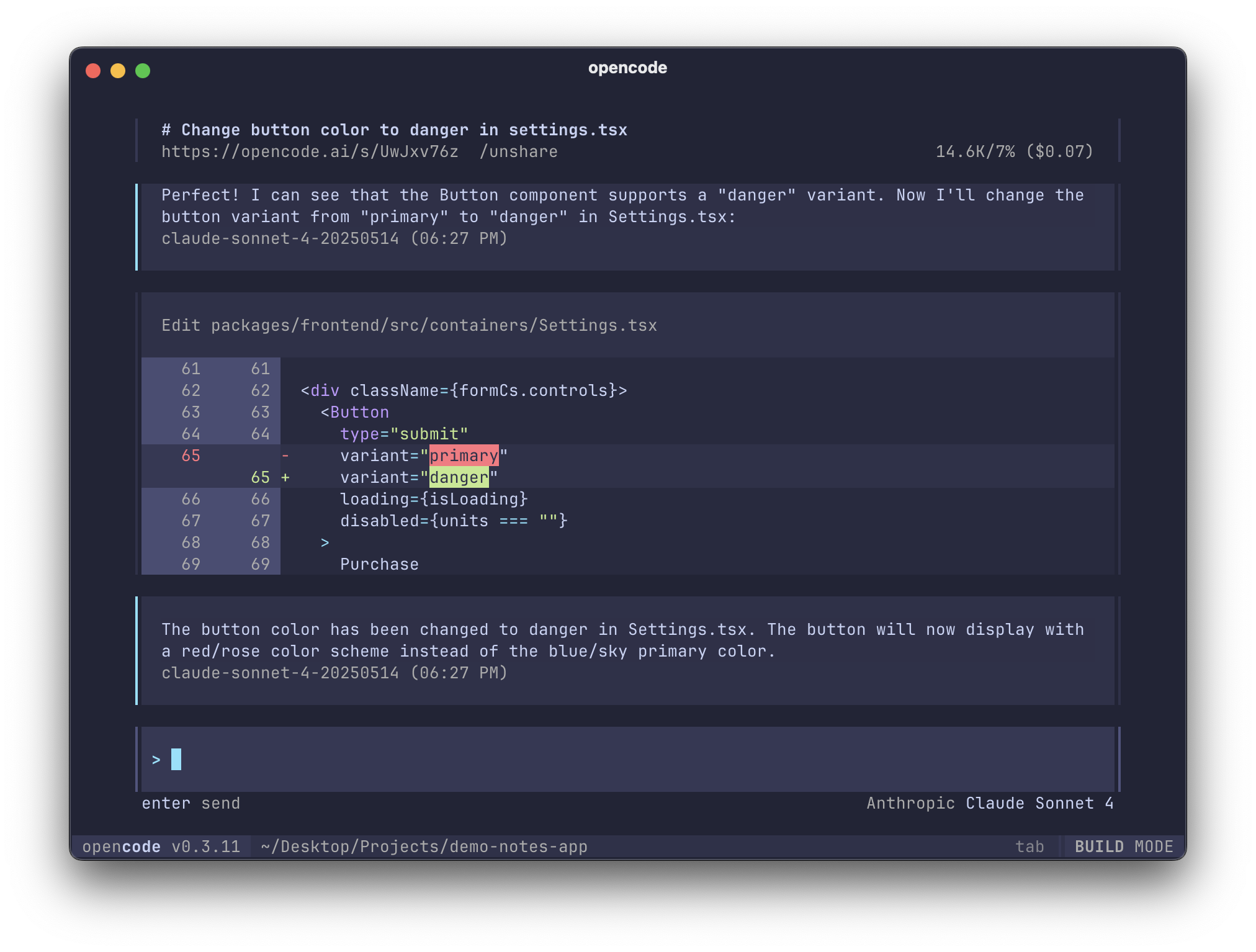

Plan / Build 双模式

Plan:仅分析与拆解方案,不直接改代码;Build:按确认过的计划执行改动。

适用价值:

-

- 降低“理解偏差”导致的反复修改

- 显性化“需求评审 + 设计讨论”步骤,便于审计与回溯

- 将“能不能改”与“怎么改”拆分,匹配团队的变更门禁策略

多 Agent + 多会话

针对同一项目可并行创建多个会话,不同 Agent 专责不同任务;通过 @general 等通用 Agent 处理跨文件分析或复杂搜索。

价值在于贴近真实工程中的角色分工(如“测试设计”“重构”“依赖升级”)并可并行推进。

MCP + Skills 扩展

MCP(Model Context Protocol)用于安全、可控地接入外部系统(如 Sentry、GitHub、内部知识库/工单系统);

Skills 将可复用的工程经验沉淀为“能力模板”(如发布流程、CR 规范、CI 检查),让团队把“方法论”落成可执行资产。

四、安装与快速上手

安装方式

# 一键安装(官方脚本) curl -fsSL https://opencode.ai/install | bash # macOS / Linux brew install opencode # Windows choco install opencode scoop install extras/opencode # Node npm install -g opencode-ai # Docker docker run -it --rm ghcr.io/anomalyco/opencode

桌面版(Beta)与 IDE 插件可在 opencode.ai/download 获取。

启动与初始化

cd your-project opencode /init # 生成 AGENTS.md(项目“入职手册”)

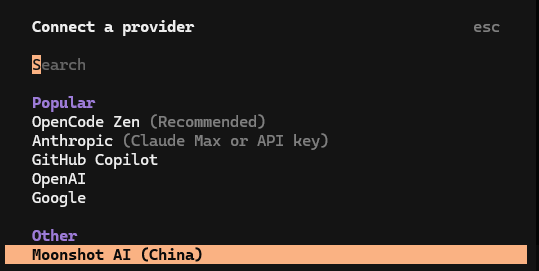

/connect # 选择模型 Provider 并填入 API Key(本地保存,不上传)

将 AGENTS.md 与相关配置纳入版本管理(Git),便于团队共享与审计。

典型用法

非交互模式:opencode run "Explain how closures work in JavaScript"(适合脚本/CI)

服务端/客户端分离:服务端 opencode serve,本地或移动端 opencode attach http://server-ip:4096

Web 界面:opencode web(浏览器操作,无需终端)

五、模型与成本管理

模型选择:OpenAI、Anthropic、Gemini、DeepSeek、Groq、Together、Fireworks、OpenRouter、本地模型(Ollama/LM Studio/llama.cpp)等。

成本策略:按任务类型选择不同模型(如“Plan”用强推理模型,“Build”用性价比模型;批量任务优先本地模型)。

密钥与路由:密钥本地保存,可接企业代理/私有网关;建议结合访问白名单/速率限制策略。

示例价格(以撰稿时公开价为参考,具体以各 Provider 官方页面为准):

- OpenAI GPT-4o:约 $5 / $15(输入/输出,百万 tokens)

- Anthropic Claude 3.5 Sonnet:约 $3 / $15(输入/输出,百万 tokens)

- DeepSeek(如 V3/R1):低于同代旗舰,适合批量生成与探索

建议:在 OpenCode 层面建立“模型选型与使用准则”,将不同任务映射到不同模型,以平衡质量与成本。

结语

如果你把 AI 当“代码生成器”,OpenCode 可能显得偏“重”;但如果你把它当“工程协作者”,它提供了把 AI 真正纳入流程管理的关键部件:计划与执行分离、可版本化的 Agent 配置、可审计的上下文、可扩展的工具接入。

我的建议是先在一个稳定维护的仓库试点:明确 Plan/Build 的边界与验收标准,沉淀 2–3 个可复用的 Skills,再逐步扩展到更多项目。

它不追求“炫技式的即时效果”,而是让团队在真实环境里可持续地用好 AI。