最近在浏览 AI 开源生态时,发现数据标注工具的演进方向很有意思。不再是单一的"全能工具"竞争,而是出现了明显的功能分化——有的做多模态通用,有的瞄准大模型对话场景,有的回归 NLP 本质。这种分化反映了 AI 工程实践的成熟:不同阶段的项目对标注工具的需求差异很大。今天我想从产品经理的角度,对三个热门开源项目进行结构化的梳理分析。

一、Label Studio:多模态标注的通用方案

项目基本信息

GitHub Star:18.5k+|项目地址:https://github.com/HumanSignal/label-studio

核心定位

Label Studio 将自己定位为综合型标注平台,覆盖从计算机视觉到 NLP、再到多模态融合的全链路数据类型。这种"大而全"的策略意味着它在单一领域可能不如专用工具精细,但对于需要统一管理多类型数据的团队很有吸引力。

支持的数据类型与应用场景

计算机视觉方面包括:图像分类、目标检测(Bounding Box)、语义分割、关键点标注、多边形绘制。典型应用如自动驾驶场景标注(车辆、行人、交通标志识别)、医疗影像处理(病灶检测、器官分割)、工业质检流程(缺陷检测、产品分类)。

自然语言处理方面包括:文本分类、命名实体识别、情感分析、关系抽取。实际应用场景涉及智能客服训练数据准备、舆情分析系统、知识图谱构建等。

此外还支持音频处理(语音识别、音频分类)、时序数据标注和视频帧级标注。

核心功能模块

(1)标注界面配置机制

Label Studio 采用 XML 配置文件定义标注界面,用户可以在不涉及编程的前提下自定义标注任务。举例:

这种设计降低了技术门槛,但相比硬编码方式也带来了灵活性的权衡。

(2)数据管理与预标注

支持 JSON、CSV、图片文件夹等多种格式的批量导入。更关键的是预标注功能——用户可以接入现有模型进行自动标注,然后由人工进行修正。这种人-机结合的流程在大规模数据集处理中能显著提升效率。

(3)AI 辅助能力

Label Studio 集成了主流机器学习框架(TensorFlow、PyTorch、Hugging Face),支持主动学习机制——模型可以自动挑选置信度低的样本优先标注,避免浪费标注资源。同时提供 API 接口,允许用户集成自有模型。

(4)团队协作框架

支持多角色权限管理(管理员、标注员、审核员分权),标注质量控制通过多人标注一致性检查实现,进度追踪仪表盘提供可视化的团队状态监控。

部署与成本

Label Studio 提供 Docker 部署、云服务版本和开源自托管版本。对于中型团队,自托管版本成本相对可控,但需要一定的基础设施投入。

二、LabelLLM:大模型训练数据标注专用工具

项目基本信息

GitHub Star:2.8k+|项目地址:https://github.com/opendatalab/LabelLLM|维护方:OpenDataLab(上海 AI 实验室)

核心定位

LabelLLM 是垂直化产品的典型代表,瞄准大语言模型的训练数据准备环节。它放弃了通用性,换来了对 LLM 特定流程的深度支持。在 RLHF、指令微调等新型 LLM 工程流程越来越重要的今天,这种专用工具的价值在上升。

标注任务类型与应用场景

RLHF(Reinforcement Learning from Human Feedback)数据准备是核心场景,包括人类反馈标注(将对话回复评分为 Helpful/Harmless)、偏好对比标注(A/B 测试式对比)、拒绝响应标注(标记不安全或无关的回复)。

指令微调(Instruction Tuning)数据集标注涉及 Instruction-Response 对的标注、多轮对话上下文标注、角色扮演数据集准备。

模型评估支持对话质量评分、事实性检查、安全性审核等维度。

核心功能差异

(1)对话展示与交互设计

与通用文本标注工具不同,LabelLLM 针对多轮对话场景优化了界面:清晰展示对话历史和上下文,支持键盘快捷键快速标注,预设常见标注类型(事实性、有用性、安全性),减少重复操作。

(2)质量控制机制

采用 Kappa 系数自动计算多标注员的一致性,支持分级审核流程(初标→专家审核→复审),异常检测能识别标注时间过短或标注模式异常的数据,主动预警低质标注。

(3)训练格式输出

支持 Alpaca、ShareGPT、自定义 JSON Schema 等主流 LLM 训练格式,避免了导出后再进行格式转换的额外工作。

适用团队画像

LabelLLM 适合已经进入模型微调阶段的团队——无论是研究机构还是企业 AI 团队。对于还在数据收集阶段、尚未明确模型训练方向的项目,这个工具的专用性可能显得过度。

三、doccano:极简主义的文本标注工具

项目基本信息

GitHub Star:9.5k+|项目地址:https://github.com/doccano/doccano

核心定位

doccano 走了与 Label Studio 相反的设计路线:放弃多模态能力,深化 NLP 标注的易用性。其设计哲学是"无多余功能,专注标注本身"。这种取舍让它成为 NLP 快速迭代项目的优先选择。

支持的标注任务

doccano 提供三种标注模式:

序列标注模式:用户通过高亮选择文本片段并打标签,适合命名实体识别任务,包括人名、地名、机构名提取,以及专业领域实体标注(药品、疾病、法律条款等)。

文本分类模式:为整段文本选择预定义的类别,应用于新闻分类、垃圾邮件检测、情感分析等任务。

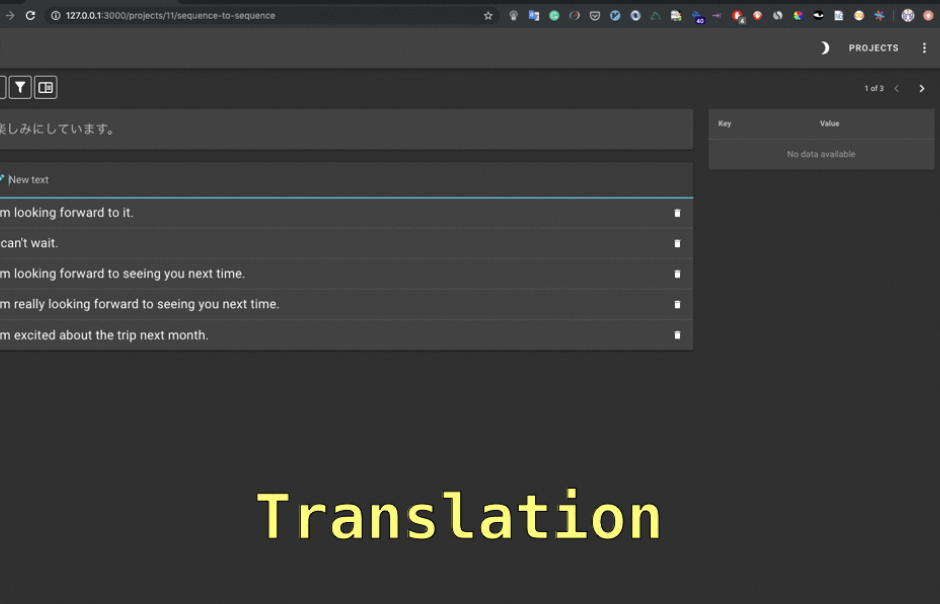

序列到序列模式:标注输入-输出对,用于机器翻译数据集、文本摘要数据集的准备。

核心功能与协作

(1)任务分配与进度管理

管理员可将数据集分配给不同的标注员,实时查看每个人的标注进度,自动检测和标记标注冲突。这套轻量级的协作机制适合小型团队。

(2)数据导入导出

支持 JSON、JSONL、CSV、Excel 等多种导入格式,导出为 CoNLL、JSONL、CSV,并允许自定义导出 schema。这种灵活性使其易于集成到现有的 NLP 工程流程中。

部署难度与性能

doccano 是三者中部署最简单的——大部分情况下 5 分钟内即可启动服务。性能表现也较为均衡,可以处理百万级纯文本数据而不出现明显瓶颈。

四、三款工具的对比维度分析

| 对比维度 | Label Studio | LabelLLM | doccano |

|---|---|---|---|

| 主要定位 | 多模态通用标注 | 大模型对话数据 | NLP 文本标注 |

| 学习曲线 | 中等(功能丰富) | 低(专注对话) | 极低(极简设计) |

| 支持的数据类型 | 图像、文本、音频、视频 | 多轮对话文本 | 纯文本 |

| 部署难度 | 中等 | 中等 | 极低 |

| 团队协作功能 | ★★★★★ | ★★★★☆ | ★★★☆☆ |

| AI 辅助能力 | ★★★★★ | ★★★★☆ | ★★☆☆☆ |

| 大数据集性能 | ★★★★☆ | ★★★★☆ | ★★★★★ |

| 社区活跃度 | 极高 | 中等 | 高 |

五、选型建议与使用场景

选择 Label Studio 的适用条件:

• 项目涉及多种数据类型(图像 + 文本 + 音频混合)的标注

• 团队规模较大(10 人以上),需要完善的权限控制与进度追踪

• 已有现成的预训练模型可用于预标注,希望降低人工标注成本

• 对数据质量有严格要求,需要多轮审核机制

选择 LabelLLM 的适用条件:

• 团队正在进行大语言模型的微调或 RLHF 实验

• 需要标注对话质量、人类偏好等 LLM 特定维度的数据

• 希望输出的数据格式能直接兼容主流 LLM 框架(LangChain、LlamaIndex 等)

• 对标注团队的质量控制有较高要求

选择 doccano 的适用条件:

• 项目仅需要标注文本数据(NER、分类、翻译等)

• 团队规模较小(1-5 人),不需要复杂的权限管理

• 追求快速上线,希望最小化配置工作量

• 存量数据集已经明确,需要快速启动标注流程

六、实战案例:医疗 NER 数据集构建

假设你要构建一个医疗领域的命名实体识别数据集,包含 5000 份电子病历文本,需要标注疾病、症状、药品、检查项目、身体部位等 5 类实体。

流程设计:

第一阶段:用 doccano 的序列标注模式快速启动初标工作。3 名医学生并行标注,每人负责 1500-2000 份文本,预计 2-3 周完成。

第二阶段:1 名主治医师进行审核,检查标注的准确性和一致性。doccano 的冲突检测功能能自动识别不同标注员对同一实体的标记差异。

第三阶段:导出为 CoNLL 格式数据,用于 BERT-based 模型的微调。如果后续需要迭代,可以用模型预标注新数据,再用 Label Studio 的预标注功能快速修正。

成本对比: 如果采用商业标注服务,5000 份医疗文本的 NER 标注成本通常在 5000-10000 元。用开源工具 + 内部 3-4 人团队,成本可降低到 1000 元以内(主要是人员时间成本)。

七、总结与建议

从我的观察看,数据标注工具的发展正在从"大而全"向"小而精"分化。这个趋势的背后是 AI 工程实践的细分化——不同的团队和项目有不同的需求,单一工具很难同时优化多个维度。

Label Studio 的强项在于集成度高,适合已经有成熟工程体系的大团队;LabelLLM 的价值在于对新兴 LLM 工程流程的深入支持,随着 RLHF 和指令微调变得更加普遍,这类工具会越来越重要;doccano 则是小团队和快速迭代的最佳选择。

实际应用中,我的建议是:

不必二选一。可以根据项目的不同阶段使用不同工具。例如:初期用 doccano 快速积累 NLP 标注数据,后期如果涉及多模态融合,再迁移到 Label Studio;如果要做模型微调,则在完成初期标注后引入 LabelLLM 处理对话类数据。

关键是理解每个工具的设计取舍和适用边界,而不是盲目追求"功能最全"。开源工具的优势恰恰在于这种灵活性——允许你为不同阶段的需求选择最合适的方案。

相关资源链接:

• Label Studio:https://github.com/HumanSignal/label-studio

• LabelLLM:https://github.com/opendatalab/LabelLLM

• doccano:https://github.com/doccano/doccano