之前我曾介绍过 Seko 这款 AI 视频工具,今天想再和大家聊聊它的新变化和我最近的一些使用体验。

最近,Seko 也做了很优化,上线Seko2.0多剧集模式,而且新增角色/场景编辑功能,精准控制角色形象与场景。

它不只是一个视频生成工具,更像是一个为视频创作设计的Agent系统,从剧本生成、角色管理、分镜创作,到最终的视频合成和导出,整个链路被串联在一个产品内。

今天就实测一下,看看全新2.0的玩法怎么样!

为什么创作流程比单个模型更重要

做过视频的人都知道一个道理:视频的灵魂在故事,不在画面。

我见过太多AI视频,画面精美但逻辑混乱、角色不统一、场景设定漂移。

这些问题的根源不在于模型本身不行,而在于创作过程被碎片化了。

创作者需要在多个工具间反复切换:先在A工具里写剧本,再到B工具生成画面,再用C工具处理细节……每一次切换,都是一次信息损失。

Seko 2.0版本的更新,让我看到了另一种可能性。

它核心做了三件事:

| 更新维度 | 具体功能 | 解决的问题 |

|---|---|---|

| 多剧集记忆管理 | 支持跨集的角色、场景上下文共享 | 确保连续剧集中人物形象、场景风格的一致性 |

| 模型集成化 | 内置可灵、Vidu等业界头部模型+自研模型 | 让创作者在同一界面选择最适合的能力,而非被单一模型限制 |

| 一站式工作流 | 从故事设计→分镜生成→视频合成→导出 | 把创作重心拉回到内容本身,而非工具操作 |

Seko2.0实操教程

目前只支持手机号登录,目前邀请的活动:每成功邀请1位好友注册,即可双方各获得100积分

注册地址:https://seko.sensetime.com/invite/6Y8J2YSN (这是我的邀请,也可以换成你的)

第一步:定义故事框架和主体角色

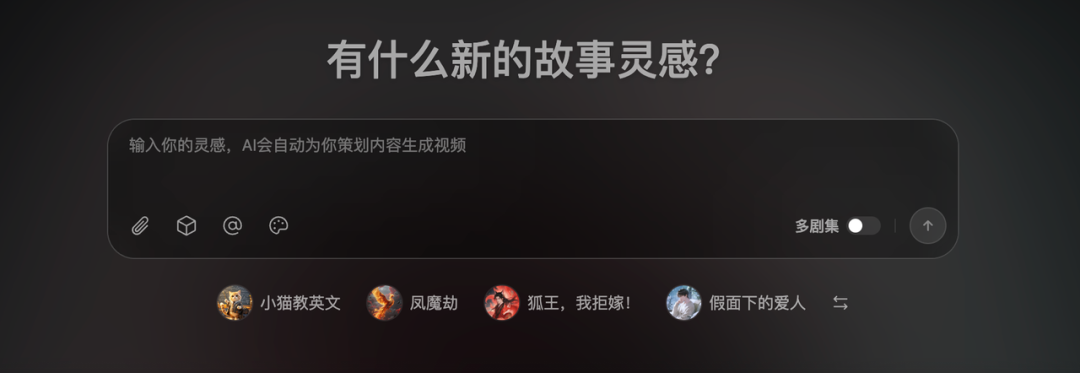

打开Seko,你会看到的第一个输入框是"灵感",而非传统产品的"输入关键词生成视频"。

这个设计差异看似细微,但它改变了整个创作的起点。

操作方式:

如果你只有一个模糊的想法,直接在灵感框输入(比如"一个机甲战士在城市中苏醒"),Seko会将其扩展为结构化的剧本概要

如果你已有详细剧本,可通过附件功能上传文本或PDF

完成故事框架后,点击"添加主体",为故事中的主要角色和场景创建参考设定

主体创建的两种方式:

- 本地上传:提供已有的角色或场景参考图片

- AI生成:通过描述生成AI设计的角色形象(支持选择生成模型,如可灵等)

这一步的关键在于提前锚定视觉风格。一旦主体被创建,后续所有涉及这个角色或场景的内容生成都会参考这个设定,避免了"同一个人物在不同镜头中长相不同"的常见问题。

第二步:创作多剧集故事结构

操作流程:

点击已创建的主体,粘贴或输入剧本灵感

打开"多剧集"选项,告诉系统这是连续故事

点击"生成第一集大纲",系统会输出:故事梗概、美术风格定义、主体和场景列表、分镜剧本

在左下角对话框中进行必要调整(比如"第二场景改为室内""角色情绪调整为更焦虑")

确认大纲后,系统进入创作阶段

第一集完成后,点击"创建下一集",重复流程即可

关键特性:多集之间自动共享记忆,系统会记住第一集的角色设定、场景风格、故事背景,确保第二集、第三集的生成结果保持一致性,而非每集都是独立生成。

第三步:分镜图片生成与调整

基础操作:

- 进入第一集编辑界面

- 右下角选择图片模型(如Seko Image)和输出比例(16:9、竖屏等)

- 点击"生成分镜",系统基于分镜剧本逐帧生成图片

图片调整的两种策略:

| 调整幅度 | 推荐方式 | 适用场景 |

|---|---|---|

| 细节修改 | 引用改图 | 只改某个细节(如改英文字为中文、调整光影等) |

| 大幅改动 | 重新编辑 | 改变构图、替换主体、重新设定场景 |

重新编辑的操作细节:

点击"重新编辑",系统会把该图片的完整提示词显示在左下角对话框

直接编辑提示词(比如"机甲体型改为更小、更符合第一集的设定")

重新选择模型和参数后生成

如果需要调用之前定义的主体来修改,可直接在对话框中引用(系统会识别已有的主体库),这样能确保角色形态始终保持一致

第四步:配音与声音设计

操作方式:

每一个分镜下方都有配音功能入口

点击后可输入台词或自动识别分镜对应的文本

系统生成配音后,可以调整:

音色:选择不同的声线

情绪:切换语气(温和、紧张、兴奋等)

语速:调整朗读快慢

试听满意后确认

这个功能的优势在于不需要跳转到专业配音工具,直接在创作界面内完成,保持了工作流的连贯性。

第五步:从静帧到动态视频

转视频操作:

点击分镜图片下方的"转视频"按钮

系统弹出该图片对应的视频提示词和参数

可选上传自定义的尾帧图片,或直接使用下一个分镜的首帧

选择视频模型(如Vidu、可灵等)和时长

点击生成

批量处理:如果一集有多个分镜,逐个点击较为耗时。右上角提供"一键转视频"功能,可批量将所有分镜转换为视频片段。

第六步:音乐与最终合成

背景音乐选择:

Seko会基于故事风格为每一集设计推荐的BGM

如果不满意系统推荐,可自行上传已准备好的音乐文件

导出选项:

导出完整视频:包含视频、配音、BGM的成片

导出全部分镜:输出所有的静帧和视频片段,方便后续在专业剪辑工具中进一步处理

第七步:故事版视图的高效管理

当一集包含多个分镜时,单帧编辑模式可能效率较低。Seko提供"故事版视图",让你能一览所有分镜的缩略图排列,支持:

- 快速添加新分镜

- 拖拽调换分镜顺序

- 批量删除不需要的分镜

- 一次性预览整集的视觉流

为什么这个流程设计值得关注

1. 链路的连贯性降低了创作成本

传统AI视频创作的痛点是工具碎片化。创作者需要在剧本工具、图像生成工具、视频生成工具、剪辑工具间反复切换,每次切换都伴随信息重新输入和素材重新搬运。Seko把这一切整合在一个界面内,创作者的精力可以完全集中在"故事如何讲",而非"怎样在各工具间协调"。

2. 多集记忆解决了连续剧的核心问题

做过短剧的团队都知道:多集之间的连贯性是最大的挑战。Seko通过让系统记住每一集的设定并在后续集数中应用,避免了"同一个角色在不同集数中突然换脸"的问题。这不仅提升了成片质量,也显著降低了人工审核和修改的成本。

3. 模型的开放性给了创作者更多选择

市面上没有哪个单一模型在所有场景下都最优。Seko集成了业界头部的可灵、Vidu等模型,让创作者能根据具体需求选择最合适的能力,而非被某个产品的默认模型限制。同时它也在打磨自研模型,这给了整个生态更多的创新空间。

结语

如果你正在考虑用AI快速制作短剧或多集视频内容,我的建议是:不要只关注单个模型的生成效果,而要重点评估整个创作流程是否顺滑、是否能保持多集的一致性、是否能让你的团队高效协作。

从这个维度看,Seko 2.0 已经达到了一个相对成熟的阶段。

另外,商汤自研的生图模型 Seko Image 和 Seko IDX 目前处于免费试用期(至12月17日),如果有兴趣体验,现在是不错的窗口期。

希望这篇分享对你有帮助。产品的迭代速度很快,这个领域也在快速演变,我会持续跟进和体验,如果有新的发现会再和大家分享。