DeepSeekMath-V2 后,DeepSeek V3.2 正式发布,而且是同时发布两个正式版模型:

DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。

与此同时,官方网页端、App 和 API 均已更新为正式版 DeepSeek-V3.2,可以去用了~

新模型技术报告已同步发布:

https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.2/resolve/master/assets/paper.pdf

其实两个月前,DeepSeek 就发布了实验版 V3.2-Exp,说是要收集用户反馈。这次正式版终于来了一波大的更新,一起来看看都有哪些重大升级!

版本概述

DeepSeek-V3.2(标准版)

标准版的目标是平衡推理能力与输出长度,更适合日常使用

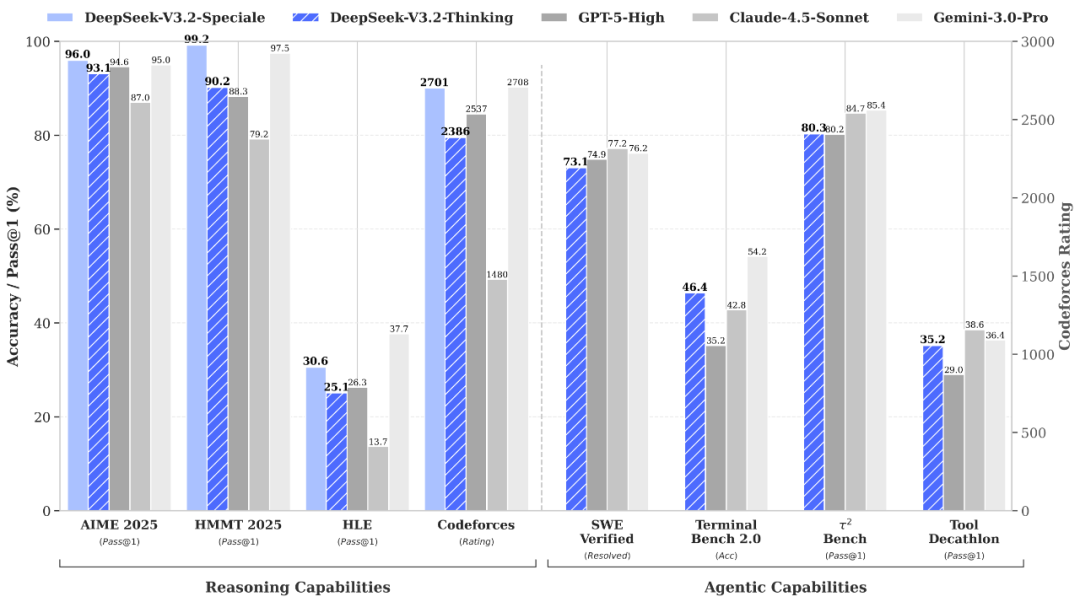

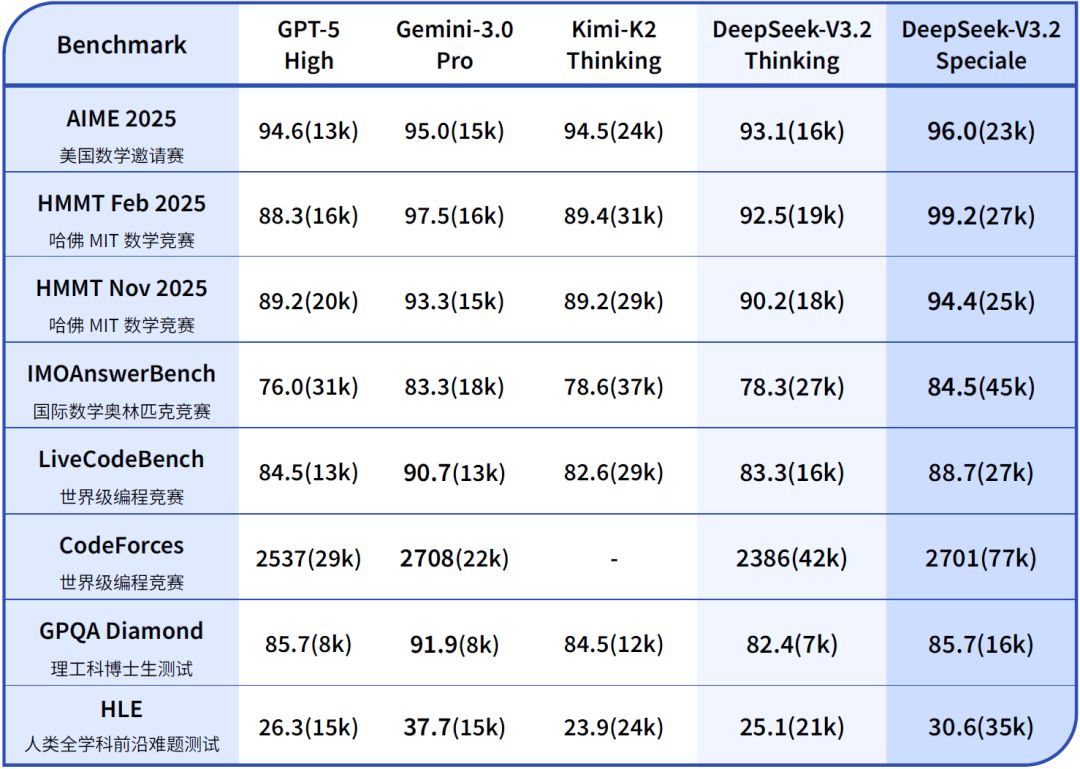

例如问答场景和通用 Agent 任务场景。在公开的推理类 Benchmark 测试中,从公布的基准测试数据来看,确实和 GPT-5 High 不相上下,有些指标甚至更强。,仅略低于 Gemini-3.0-Pro;

相比 Kimi-K2-Thinking,V3.2 的输出长度大幅降低,显著减少了计算开销与用户等待时间。

DeepSeek-V3.2-Speciale(研究版)

Speciale 的目标是将开源模型的推理能力推向极致,探索模型能力的边界。

V3.2-Speciale 是 DeepSeek-V3.2 的长思考增强版,同时结合了 DeepSeek-Math-V2 的定理证明能力。

该模型具备出色的指令跟随、严谨的数学证明与逻辑验证能力,在主流推理基准测试上的性能表现媲美 Gemini-3.0-Pro。

更令人瞩目的是,V3.2-Speciale 模型成功斩获 4 块金牌:IMO 2025、CMO 2025、ICPC 世界总决赛、IOI 2025。

其中,ICPC 与 IOI 成绩分别达到了人类选手第二名与第十名的水平。

在主流推理基准测试中,它和 Gemini 3 Pro 打得有来有回。

也正因为 token 消耗大、成本高,DeepSeek 官方强调这个模型目前只供研究使用,不支持工具调用,也没有针对日常对话优化。

并且,仅开放临时 API,有效期到北京时间 12 月 15 日 23:59;价格和 V3.2 一样。

DSA 稀疏注意力

V3.2(V3.2-Exp 也是)的核心架构叫做「DSA」(DeepSeek Sparse Attention)。

这是一种稀疏注意力机制。

传统注意力有个问题:每生成一个新 token,模型都要回顾所有历史内容。

计算复杂度是平方级别的。

而 DSA 的思路是:不是所有历史信息都同等重要。

它引入了一个「索引器」(Lightning Indexer),快速判断哪些 token 是关键,然后只对这些部分执行精细计算。

最终核心注意力的复杂度大幅降低。

实际效果:

在 128K 上下文长度下,V3.2 的推理成本比 V3.1-Terminus 降低了 50-70%。

Agent 能力强化

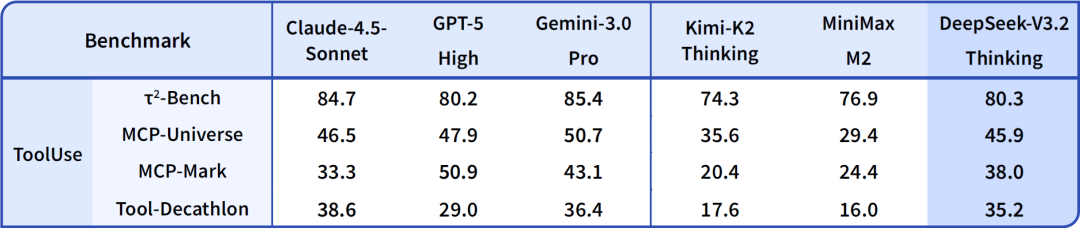

DeepSeek-V3.2 模型在智能体评测中达到了当前开源模型的最高水平,大幅缩小了开源模型与闭源模型的差距。

比如 Agent 评测 τ²-Bench 准确率 80.3%,和 GPT-5 High 基本持平。

以前,DeepSeek 的深度思考和工具调用是互斥的。

模型要么思考,要么调用工具,不能同时进行。

V3.2 解决了这个问题。

它现在可以一边思考,一边调用搜索、代码执行工具,然后基于返回的结果继续推理。

示例为通过 LobeChat 使用 DeepSeek-V3.2 的深度思考+工具调用能力得到更加详细准确的回复

工具调用

本次 API 更新支持了 DeepSeek-V3.2 思考模式下的工具调用能力。

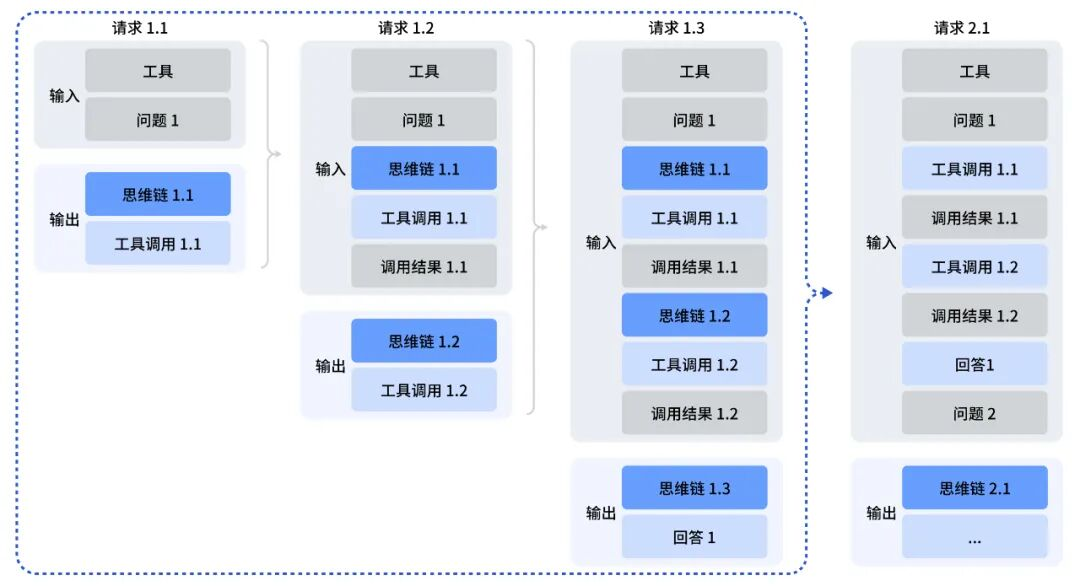

当前在思考模式下,模型能够经过多轮的思考 + 工具调用,最终给出更详尽准确的回答。下图为思考模式下进行工具调用的 API 请求示意图:

-

在回答问题 1 过程中(请求 1.1 - 1.3),模型进行了多次思考 + 工具调用后给出答案。在这个过程中,用户需回传思维链内容(reasoning_content)给 API,以让模型继续思考。

-

在下一个用户问题开始时(请求 2.1),需删除之前的思维链,并保留其它内容发送给 API。

-

更详细的使用方法请参考 API 文档:https://api-docs.deepseek.com/zh-cn/guides/thinking_mode

正式版 V3.2 还增加了对 Claude Code 的支持。根据 DeepSeek API 文档中的 Anthropic 兼容 API 指南,用户可以先安装 CC,配置环境后,就能通过 Anthropic 兼容 API 调用 DeepSeek 模型。

配置文档:https://api-docs.deepseek.com/zh-cn/guides/anthropic_api

但需要注意的是,思考模式未充分适配 Cline、RooCode 等使用非标准工具调用的组件,我们建议用户在使用此类组件时继续使用非思考模式。

定价对比

和 Kimi K2 Thinking 官方价对比,DeepSeek-V3.2 thinking 大致是:

输入命中:1 元 vs 0.2 元 → Kimi 大约 贵 5 倍

输入未命中:4 元 vs 2 元 → Kimi 大约 贵 2 倍

输出:16 元 vs 3 元 → Kimi 大约 贵 ~5.3 倍

与 Kimi K2 thinking、MiniMax M2 相比,V3.2 的整体编码思路并不完全相同,推理路径也会有自己的特色。正式版在思考与工具调用的结合上走得更远一些,这使得它在需要综合规划和调用外部工具的场景中更有潜力。