最近在体验各类 AI 开源项目的过程中,我发现了一个有趣的现象:越来越多团队都在问同一个问题——"怎样才能快速把 AI 能力落地到业务中,而不是被代码实现卡住?"

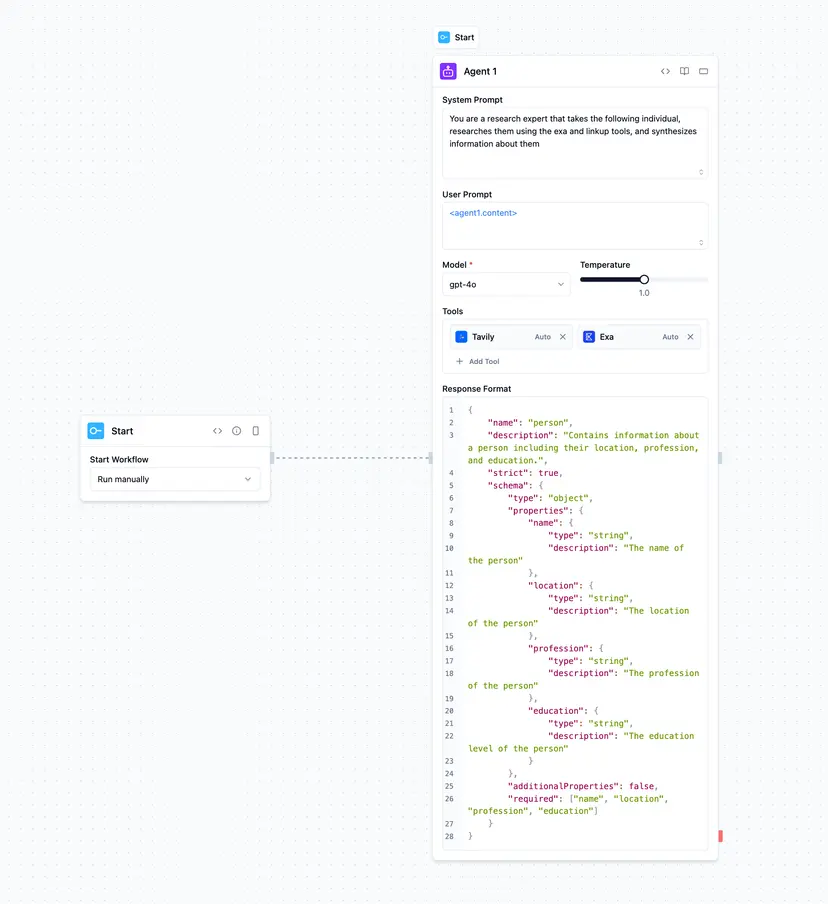

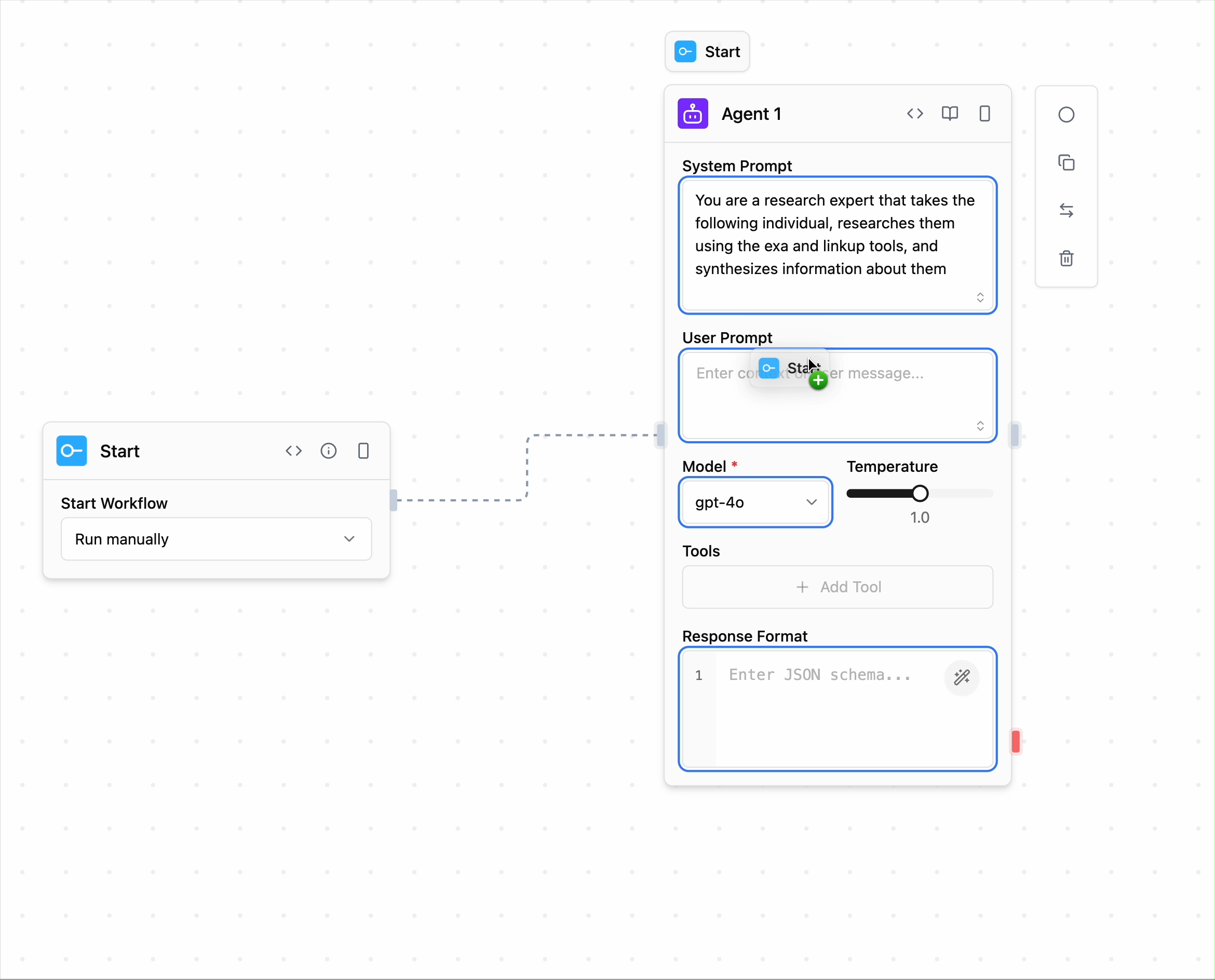

直到我接触到 Sim 这个项目,我才真正理解什么叫"一劳永逸"的解决方案。它用一个简单的设计理念彻底改变了我对 AI 工作流搭建的认知:把复杂的 LLM 编排、多服务集成、数据流转全部变成可视化画布上的拖拽操作。

如果说 LangChain 是 AI 开发者的工具箱,那 Sim 就是让产品经理、运营也能上手的"乐高积木"。今天就让我从产品角度,为你深度剖析这个项目。

核心价值

在接触 Sim 之前,我观察到市场上存在三类痛点:

- 纯代码框架门槛太高——LangChain、LlamaIndex 虽然功能强大,但需要开发者参与,业务迭代速度慢

- SaaS 产品数据隐忧——Make、Zapier 虽然易用,但企业敏感数据出云存在合规风险

- 自建方案成本高——从零开发一套可视化工作流引擎,要投入巨大的人力和时间

Sim 的出现就是为了打破这个僵局。用一句话总结它的价值主张:Google Docs 式的实时协作 + Zapier 式的无代码集成 + LangChain 式的 LLM 编排,全部私有化部署。

功能亮点

1. 60+ 预置集成,开箱即用的生态

这是 Sim 最直观的优势。官方已经接入了:

- LLM 厂商:OpenAI、Anthropic、Google、Groq 等主流模型

- 企业工具:Slack、Notion、Airtable、Gmail、Supabase

- 向量数据库:Pinecone、Weaviate

- 爬虫工具:Firecrawl

这意味着你不需要自己写 API 集成代码,直接拖拽节点即可调用。对于产品经理来说,这相当于省去了大量的需求评审和开发周期。

2. 多模型无缝切换,一条流程多个大脑

这个设计很有意思——在同一条工作流里,你可以让 GPT-4o 负责内容总结,Claude 3.7 负责文案生成,Llama3 负责本地数据处理。只需点击下拉框切换,不用改一行代码。这对于对标多个模型性能、成本的场景特别有用。

3. 本地/云端双模式,数据安全可控

这是我最看重的一点:

- 可以

npm install -g simstudio一键本地运行 - 也支持 Docker Compose 私有部署

- 集成 Ollama,敏感数据永不出网

对于金融、医疗等合规要求高的行业,这个特性简直是"定心丸"。

4. 多人实时协作,团队评审不再卡壳

画布、节点配置、运行日志全部实时同步。这意味着产品经理和开发可以像协作 Figma 一样协作 AI 工作流。我能想象的场景是:产品在画布上拖拽新节点,开发实时看到变化,直接反馈可行性。

5. 一键部署成 API,无缝嵌入现有系统

流程调试完成后,点击 Deploy,系统自动生成 REST Endpoint。这对于想快速验证 AI 功能、但又不想大动干戈改造后端的团队来说,是个巨大的生产力提升。

6. 企业级可观测,成本透明化

内置日志、链路追踪、错误重试、Token 用量仪表盘。这让 CFO 也能看懂 AI 工作流的成本结构,对于成本管理和预算规划至关重要。

技术架构

作为产品经理,我也关注技术选型背后的考量:

- 前端:Next.js App Router + ReactFlow(业界最强的画布引擎)+ Tailwind 快速迭代

- 后端运行时:Bun(相比 Node.js 快 3-4 倍,且 TypeScript 原生支持,减少类型转换开销)

- 数据库:PostgreSQL + pgvector(向量检索和记忆存储一体化)

- 实时通道:Socket.io(协作光标、日志推送秒级延迟)

- 后台任务:Trigger.dev(定时任务、事件驱动,无需维护 Cron)

- Monorepo:Turborepo(统一构建,核心 apps/sim、packages/sdk 可独立复用)

特别值得关注的架构设计:

Agent Block 统一抽象——所有 LLM 调用都通过统一接口,框架内部自动处理重试逻辑、结构化输出、Function Calling。这降低了用户的心智负担。

Tool Registry 微服务化——新增一个工具只需写 10 行 JS/TS 函数,就能变成可拖拽节点。我能想象的是:公司的老旧 SOAP 接口、内部 RPC 调用,都能快速包装进来。

Schema-Driven 类型系统——每个节点的输入/输出都有 JSON Schema 约束,运行前即可静态检查,大幅降低运行时错误。

快速上手指南

方案 A:30 秒本地体验(推荐新手)

npm install -g simstudio

simstudio --port 3000

# 浏览器打开 http://localhost:3000前置条件:本地装好 Docker。

方案 B:生产级部署(推荐企业)

git clone https://github.com/simstudioai/sim.git

cd sim

docker compose -f docker-compose.prod.yml up -d如果需要本地 GPU 跑 Ollama 模型:

docker compose --profile local-gpu -f docker-compose.ollama.yml up -d方案 C:开发模式(推荐贡献者)

git clone https://github.com/simstudioai/sim.git

bun install

bun run dev:full # 同时启动 Next.js + WebSocket + Trigger真实应用场景

场景 1:电商客服自动化

用户消息进来 → GPT-4o 识别意图 → 查询 Supabase 库存 → 生成个性化回复 → 同时发送到 Slack(内部通知)和邮件(客户回复) → 自动创建 Jira Ticket(售后跟进)。

传统方案需要后端开发 2-3 周,Sim 可能只需产品经理 2 小时搭建。

场景 2:内容工厂流水线

Firecrawl 爬取竞品文章 → Claude 3.7 总结要点 → GPT-4o 改写成微博/公众号风格 → 自动保存到 Notion Database → 生成内容日历。

这是我见过最"懒"的内容运营方案。

场景 3:金融投研报告生成

上传 PDF 财报 → 本地 Llama3 抽取财务指标(数据不出网) → Pinecone 向量比对历史数据 → 生成 BI 可视化报告 API → 前端 Dashboard 调用展示。

这个场景最能体现 Sim 的"私有化 + 多模型 + 一键 API" 的综合优势。

适合谁用?

✅ 强烈推荐:

- 产品经理——快速验证 AI 功能想法,不用等开发排期

- 运营/增长——搭建自动化工作流,释放重复劳动

- 创业公司——用最少的工程资源快速上线 AI 功能

- 企业 AI CoE——降低 AI 应用的开发成本和部署周期

⚠️ 需要评估:

- 超复杂的自定义逻辑可能还是要回到代码(虽然 Sim 支持自定义 JS 节点)

- 极高并发场景需要自己做性能优化

总结

从产品经理的角度,我认为 Sim 解决的不仅是"怎么快速搭建 AI 工作流"的问题,更重要的是降低了 AI 应用的民主化门槛。

在 AI 时代,谁能更快地从想法到落地,谁就能抢占市场。Sim 把这个周期从"周"压缩到"小时",这对于竞争激烈的行业是巨大的优势。

而且我特别欣赏的是它的开源 + 私有化的组合——既保留了开源社区的活力和透明度,又给了企业完全的数据掌控权。这在 AI 工具市场中并不常见。

如果你所在的团队最近在考虑"怎样快速上线 AI 功能",不妨花 30 秒试试 Sim。我打赌,你会改变对 AI 工作流搭建的认知。

相关资源:

GitHub:https://github.com/simstudioai/sim

官方文档:https://docs.sim.ai