深度解析Cursor 0.5版本的 @folders 命令:提升代码开发效率的必备技能

Cursor新手3分钟快速搞懂 Ask/Manual/Agent 三种模式及高级技巧

Cursor三大模式(Ask、Manual、Agent)进阶教程及功能详解

不过上面的文章也只是分享在使用Cursor中的一些功能技巧和方法,并没有系统的介绍关于模型上下文限制导致的Cursor”降智“这个问题及其解决方案,今天苏米就结合最新的工具和实践经验整理一份实用策略,帮助大家更高效地使用 Cursor。

如何判断“降智”

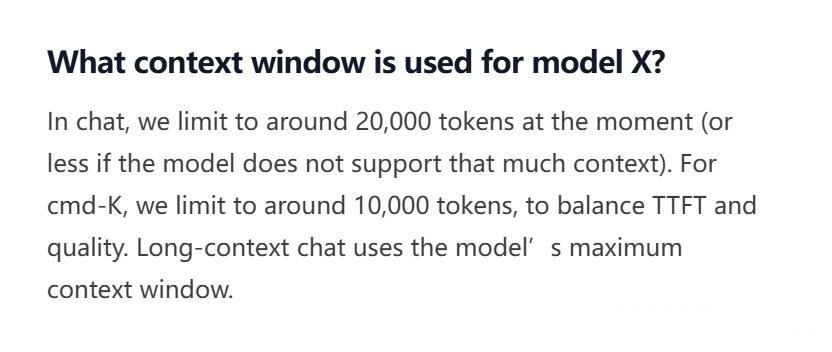

AI大模型的理解和输出质量直接依赖于上下文窗口大小(token数量)。当我们与Cursor持续交互,对话内容累积超过上下文窗口限制时,AI会"遗忘"早期的对话内容,导致回答质量下降,甚至出现前后矛盾的情况。

即使是像Gemini这样支持百万token的大模型,在Cursor中也被限制在128K的上下文窗口,这意味着长时间交互后必然会面临这个问题。

一个简单的判断方法是利用"约定"机制:在开始与Cursor交流时,设定一个特定回复方式(如“请记住以下内容”)。如果在后续交流中,Cursor不再按照约定方式回复,则说明它已经"遗忘"了初始约定,这是上下文溢出的明显信号。

五个解决方案

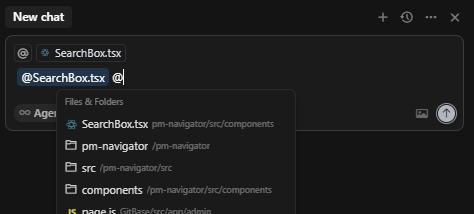

使用 @file 和 @folder 精准限定上下文

在 Cursor 的对话框中,通过输入 @ 可以调出文件或文件夹,精确指定模型需要关注的代码范围。这种方式不仅可以节省 Token,还能提高模型对当前任务的理解度。

实操方法:

-

在对话框中输入

@符号,会自动弹出可选命令 -

选择特定文件或文件夹,限定Cursor只关注这些代码

@src/components/Header.jsx 请帮我优化这个组件的性能

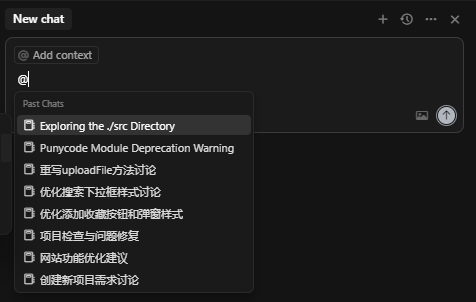

利用 @Past Chats 引用历史对话

当对话内容超出当前上下文时,可以新建一个对话框,并通过 @Past Chats 引用之前的聊天记录。这样可以保留重要的上下文信息,避免模型遗忘关键细节。

实操方法:

-

当发现Cursor回答质量下降时,开启新的对话窗口

-

使用

@Past Chats命令引用之前有价值的对话内容

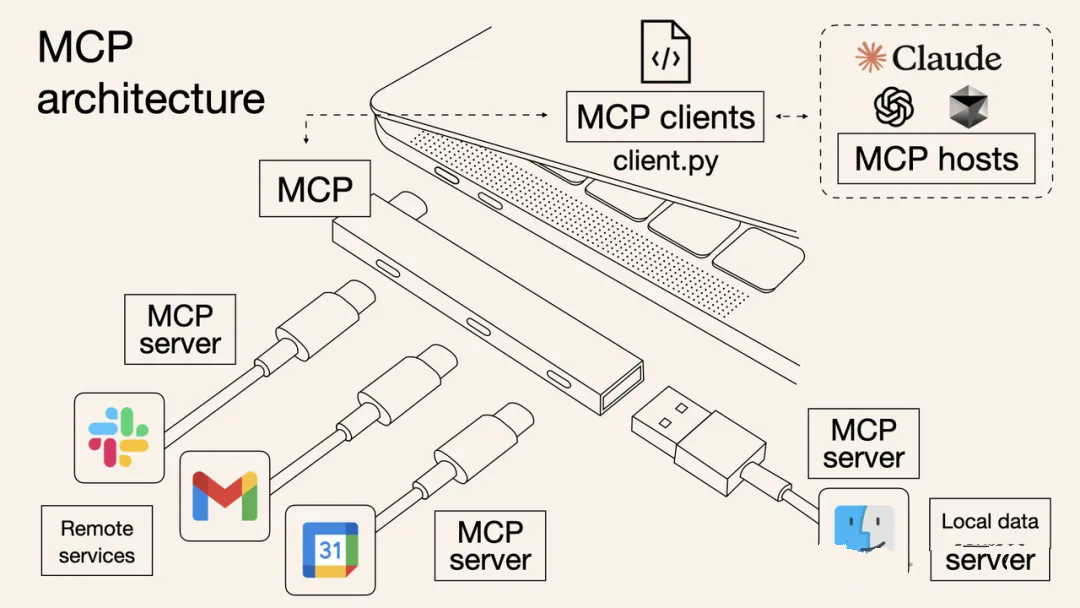

集成 MCP 服务,扩展模型能力

Model Context Protocol(MCP)是一种开放标准,允许将 Cursor 连接到外部系统和数据源。通过 MCP,可以让模型访问项目相关的文档、数据库等,增强其理解和处理复杂任务的能力。例如,可以使用 MCP 连接到 Notion、Slack、GitHub 等工具,实现更高效的协作。

实操方法:

-

在Cursor中添加MCP服务

-

配置MCP连接到外部知识源或数据库

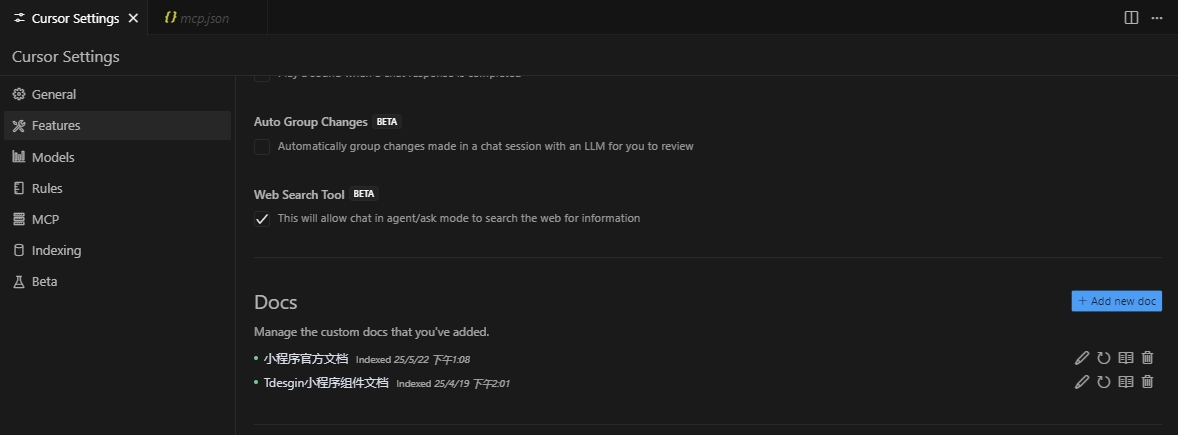

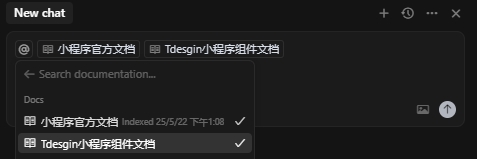

通过 @docs 引入在线知识库

在 Cursor 中,可以将在线文档添加到 Features 中,并在对话中通过 @docs 引用。这种方式可以为模型提供最新的文档信息,提升其回答的准确性和相关性。

实操方法:

-

在Features中添加相关在线文档

-

聊天中使用

@docs会提示选择已添加文档

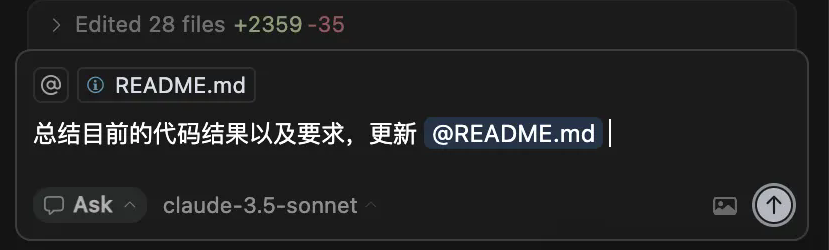

更新 README.md

在项目的不同阶段,适时地对当前进展进行总结,并将其写入 README.md 文件。在后续的对话中,可以通过 @file 引用该文件,帮助模型更好地理解项目的整体背景和历史。

实操方法:

-

在关键开发阶段,让Cursor总结当前进展

-

将总结保存为README.md或其他文档

-

后续通过

@file引用这些总结文档

请将我们讨论的认证系统设计要点总结到README.md文件中

模型选择

为获得最佳体验,建议优先选择上下文窗口更大的模型:

-

Claude 3.7 Sonnet: 提供更深入的代码理解和推理能力(支持50万token上下文)

-

Gemini 2.5 Flash: 高效处理大型代码库,反应速度快

综合策略

实际开发中,我建议结合使用以上方法:

-

开始阶段: 明确项目范围,使用

@file/folders限定相关代码 -

开发过程中: 定期让AI总结关键决策和设计模式到文档

-

遇到专业问题: 利用

@docs引入相关技术文档 -

长期项目: 设置MCP服务连接项目知识库

-

出现"降智": 立即开启新对话,使用

@Past Chats引用关键历史

结语

Cursor的AI能力虽然强大,但受限于上下文窗口大小的限制是不可避免的。通过本文介绍的策略,我们可以最大化利用Cursor的智能辅助能力,同时巧妙绕过其局限性。

随着大模型技术的发展,上下文窗口会不断扩大,但合理管理上下文、优化使用策略的能力,将始终是高效使用AI编程助手的关键技能。

希望这些实用技巧能帮助你在日常开发中更好地与Cursor协作,提升编程效率和代码质量!